-

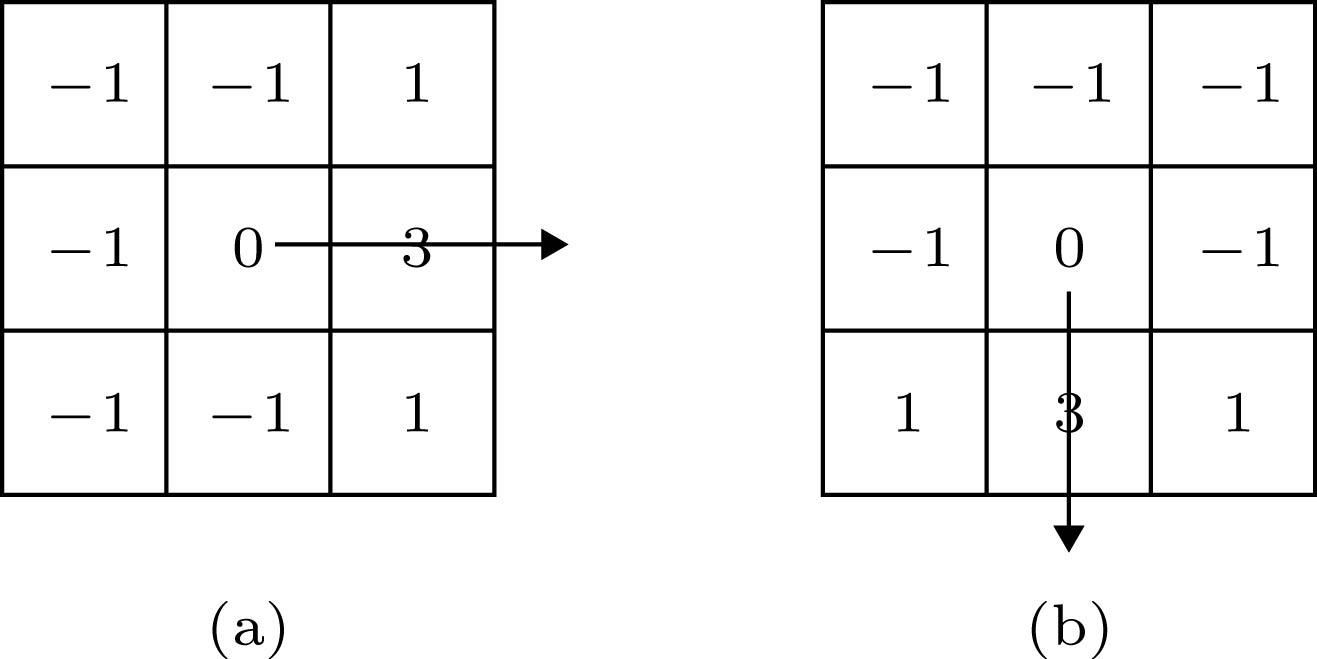

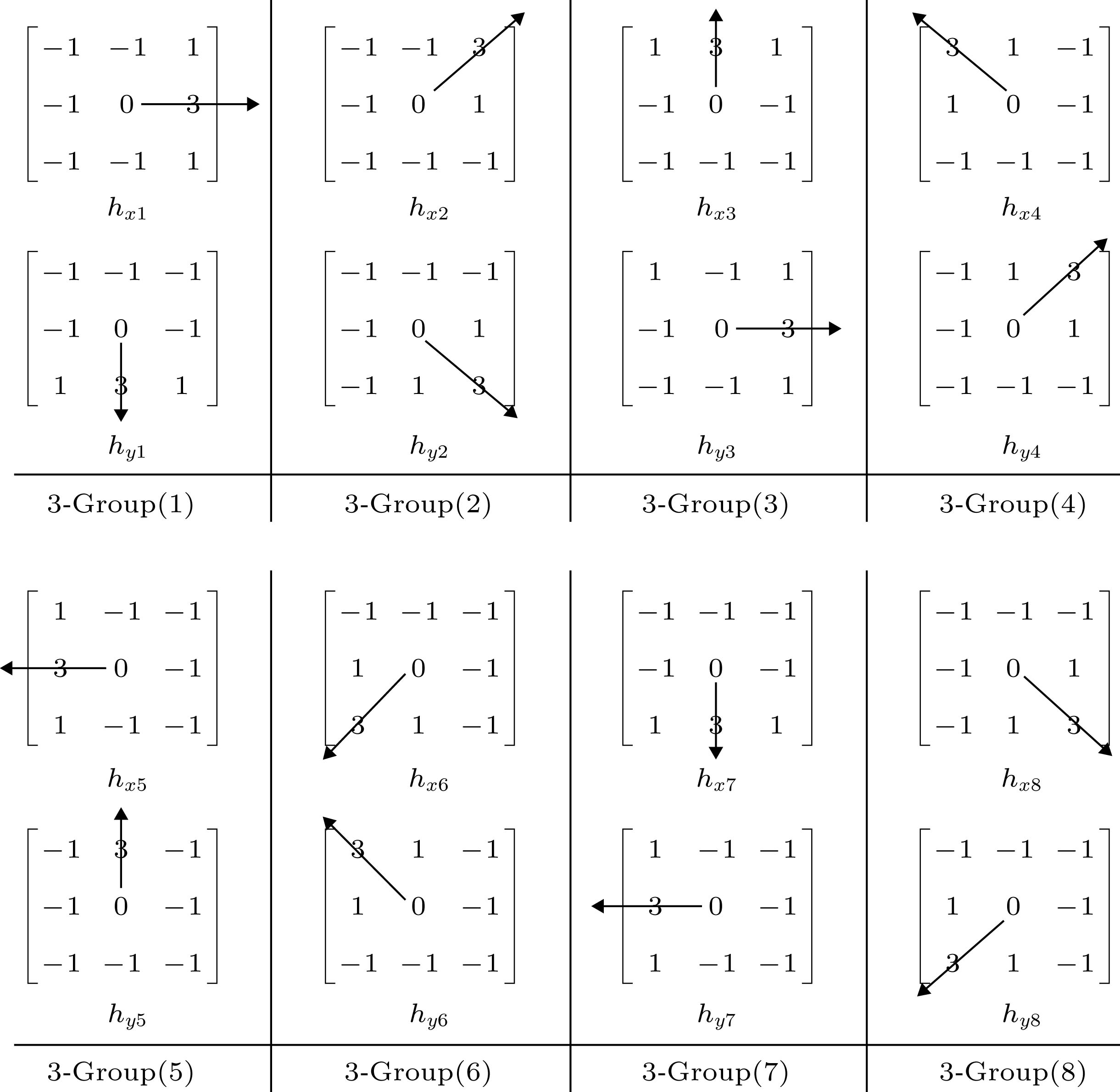

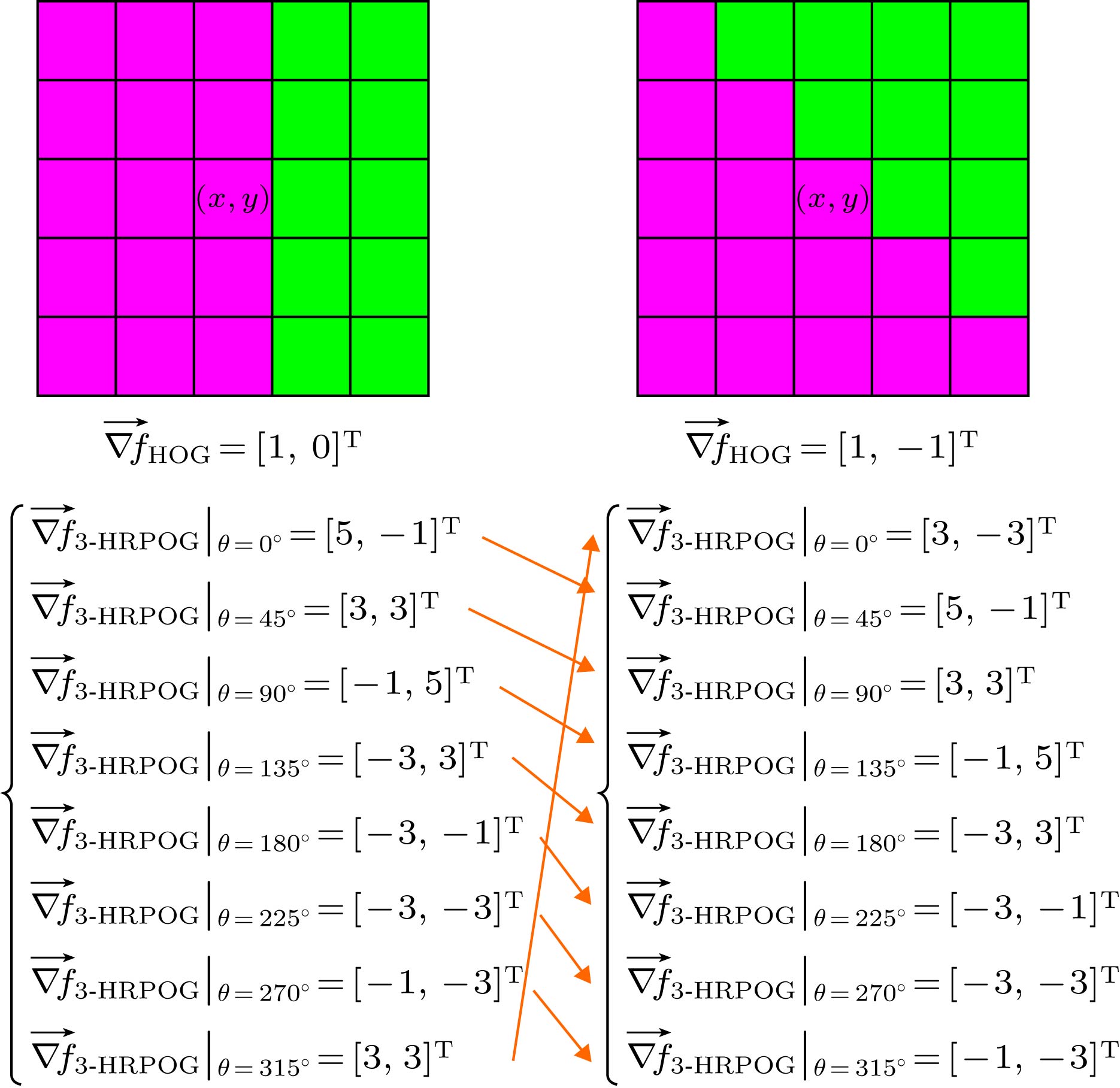

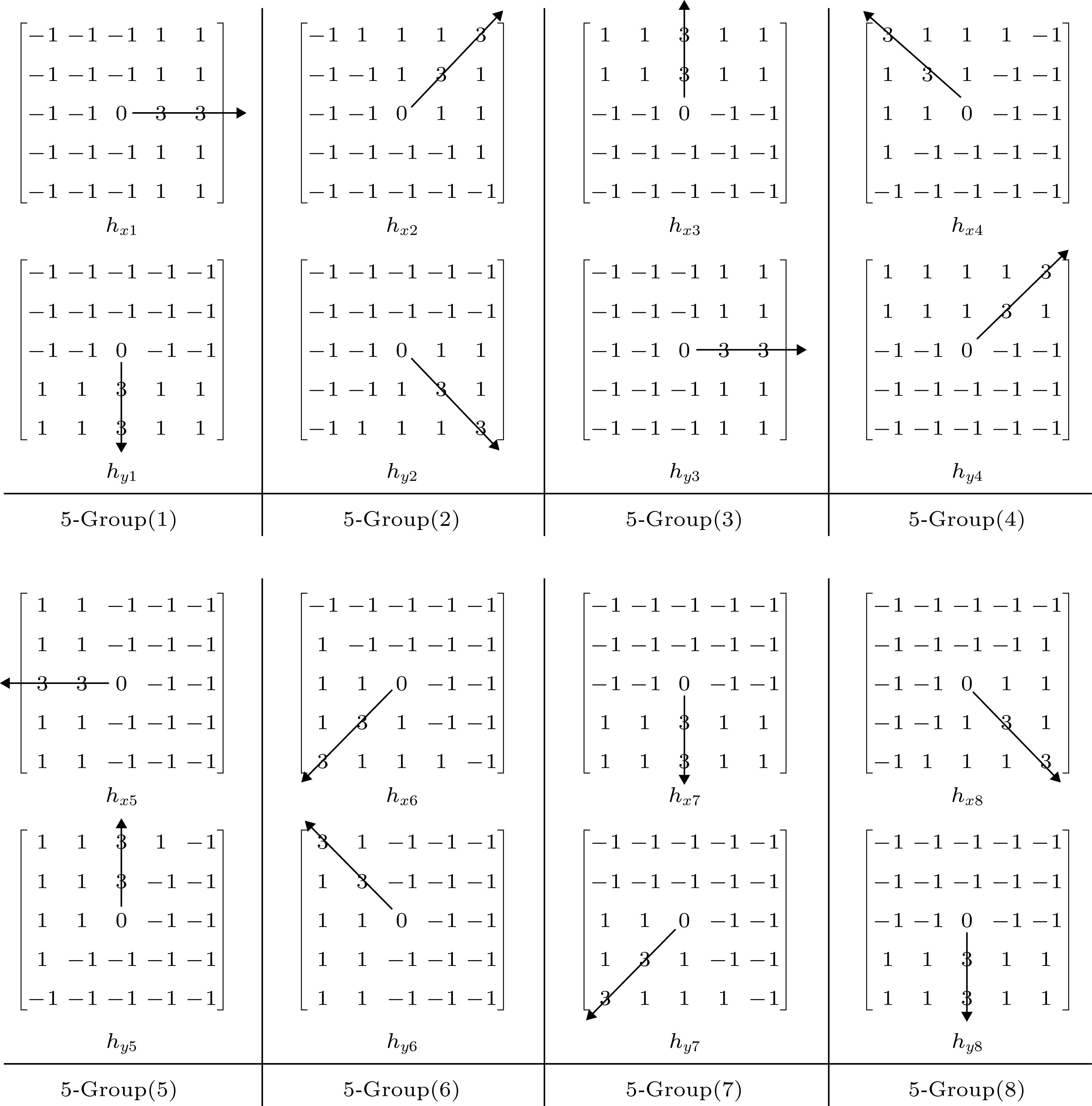

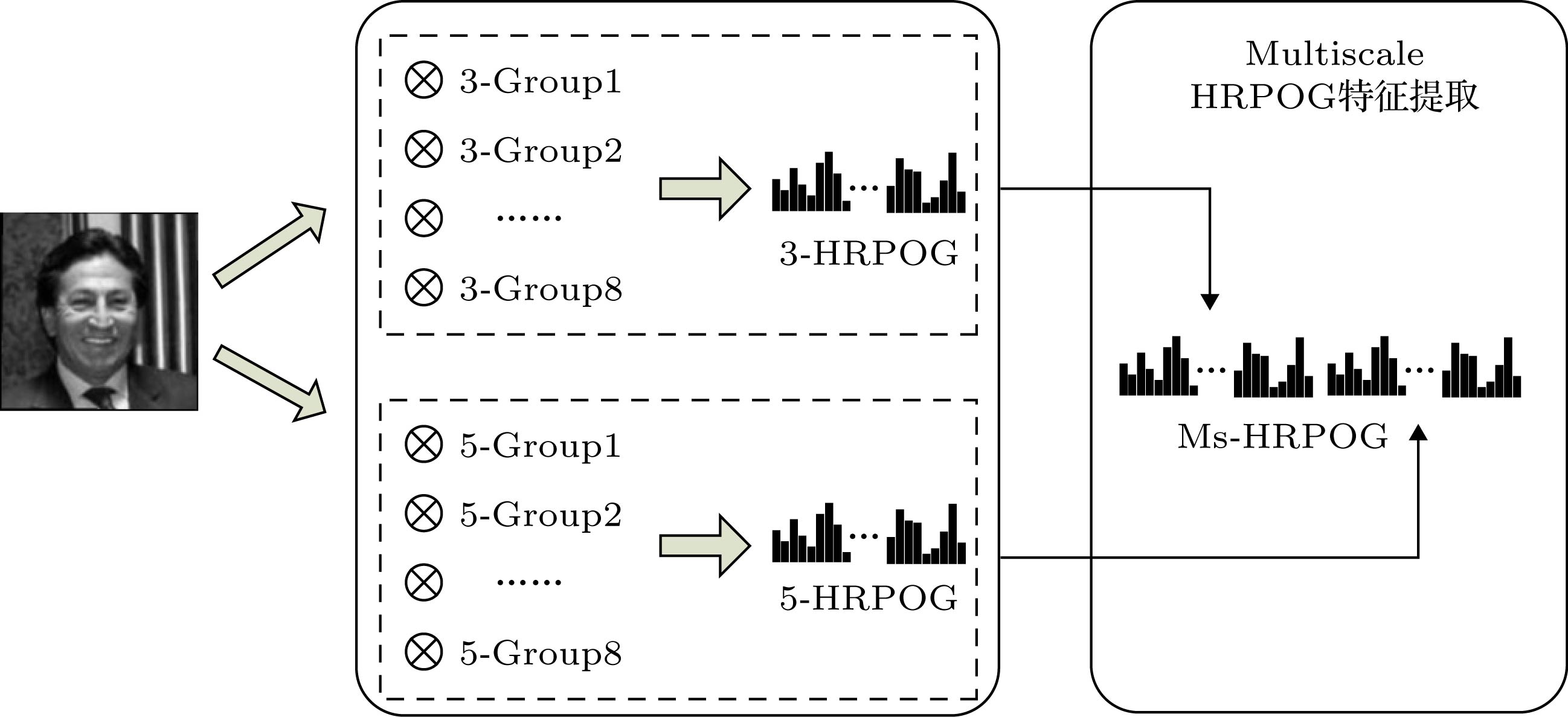

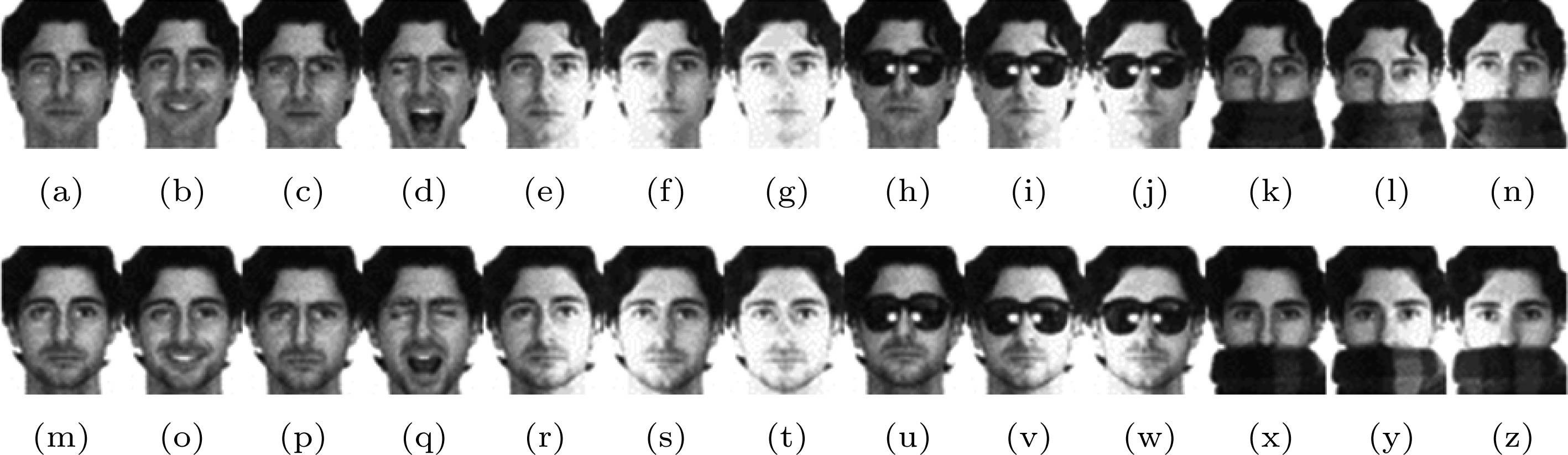

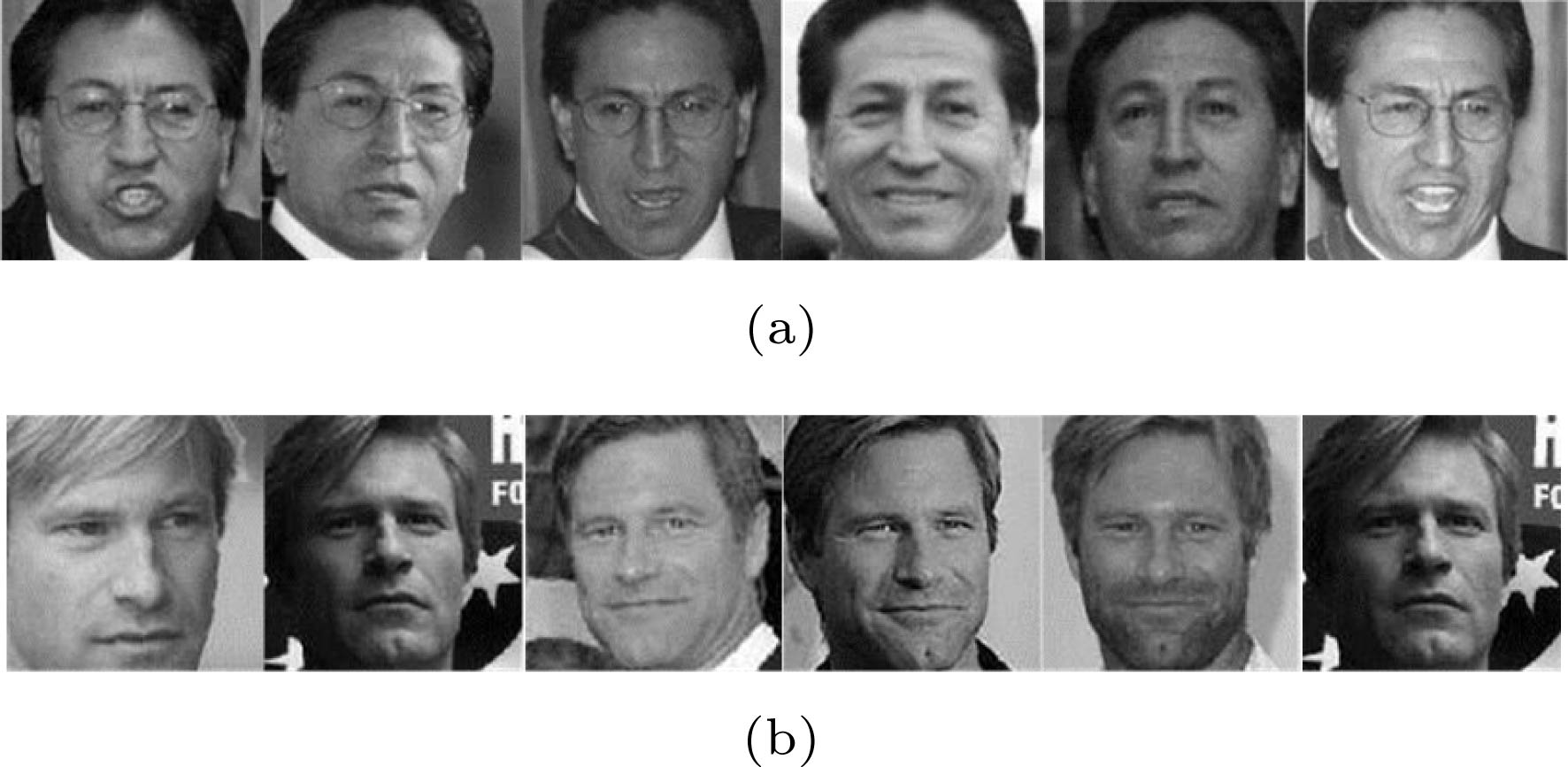

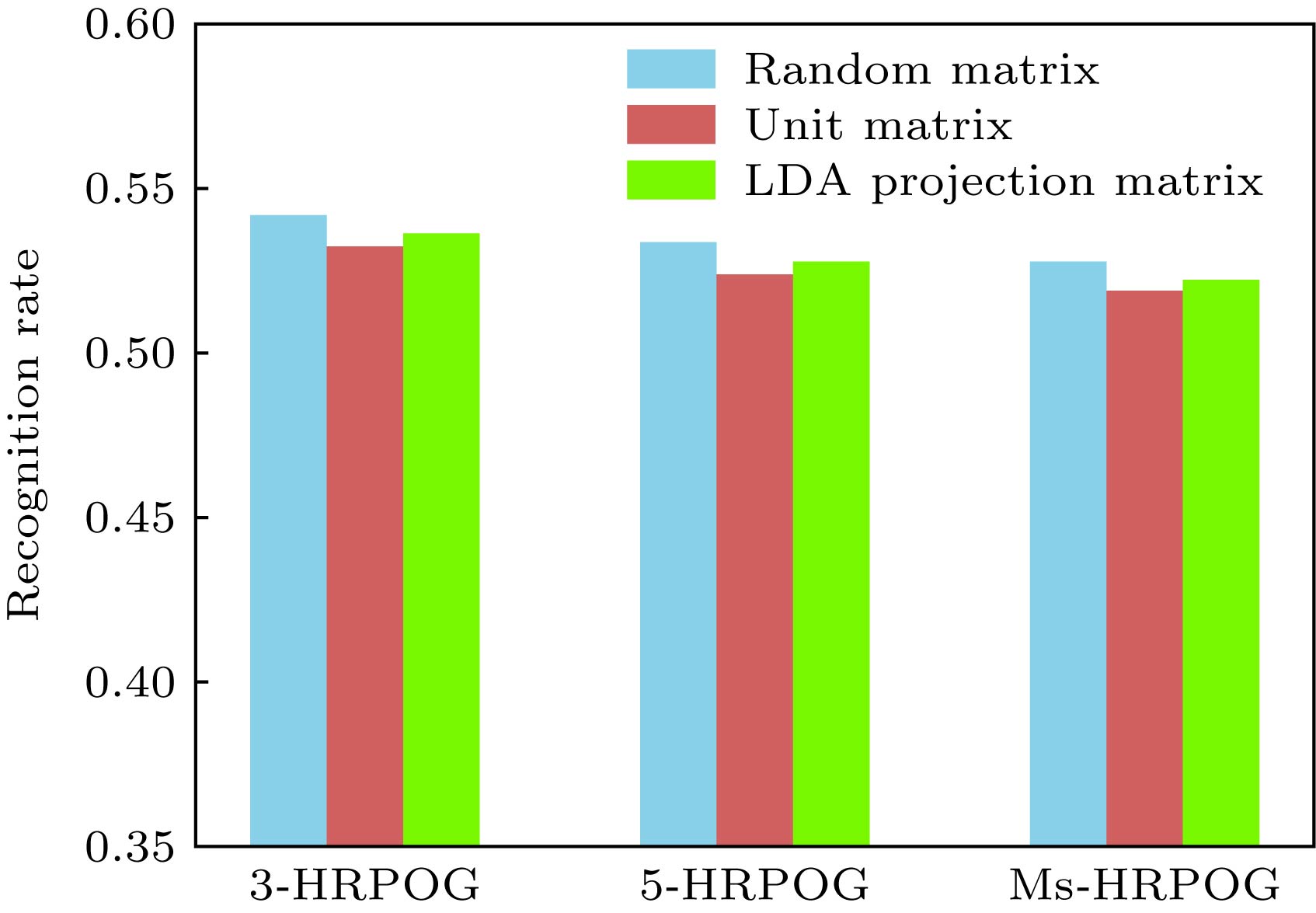

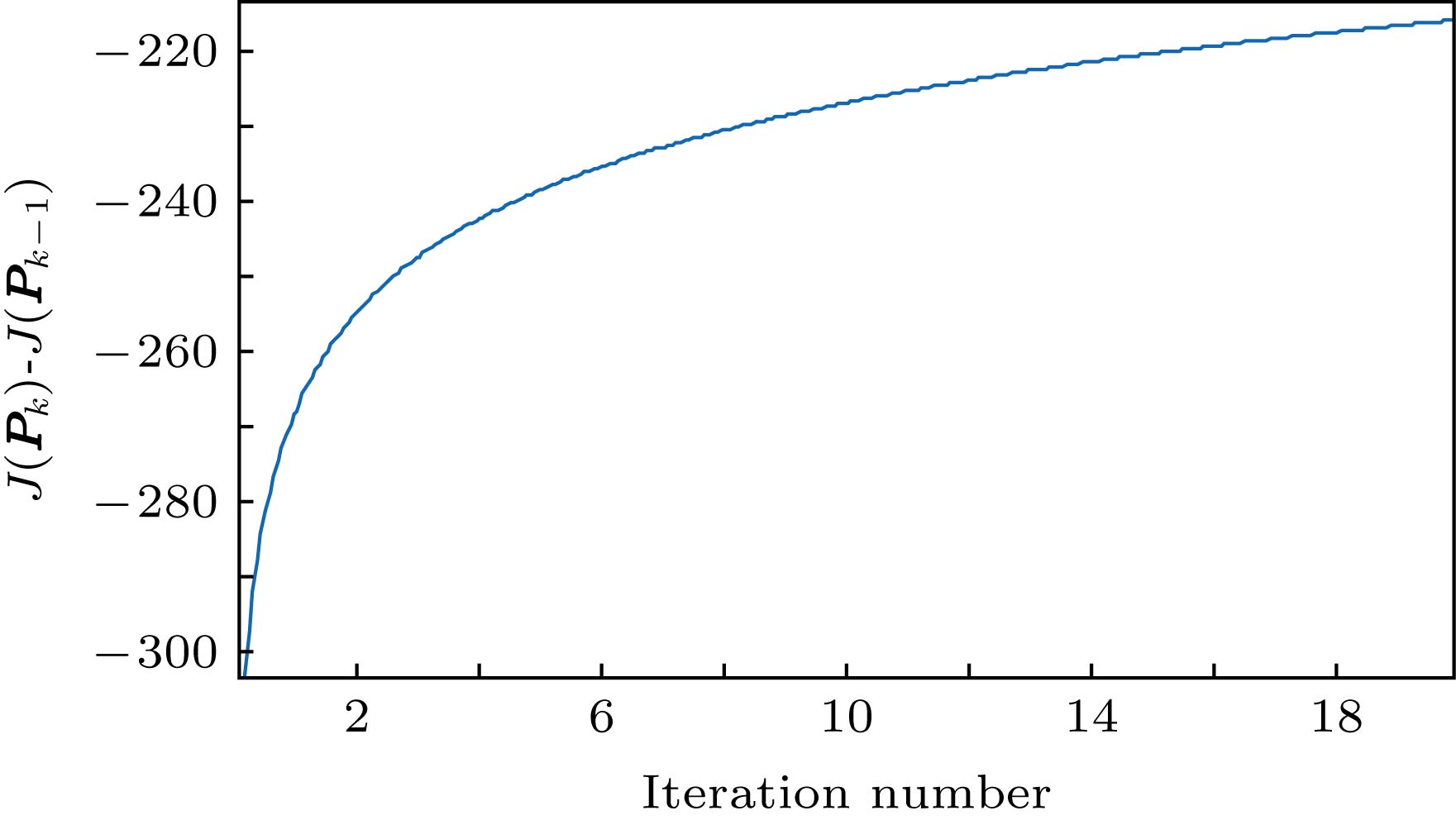

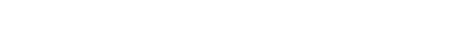

非约束环境下采集的人脸图像复杂多变, 将其直接作为字典原子用于稀疏表示分类(sparse representation based classification, SRC), 识别效果不理想. 针对该问题, 本文提出一种基于旋转主方向梯度直方图特征的判别稀疏图映射(discriminative sparse graph embedding based on histogram of rotated principal orientation gradients, DSGE-HRPOG)算法, 用于构建类内紧凑、类间分离的低维判别特征字典, 提高稀疏表示分类准确性. 首先, 采用旋转主方向梯度直方图(histogram of rotated principal orientation gradients, HRPOG)特征算子提取非约束人脸图像的多尺度多方向梯度特征, 有效去除外界干扰和像素间冗余信息, 构建稳定、鉴别的HRPOG特征字典; 其次, 引入判别稀疏图映射(discriminative sparse graph embedding, DSGE)算法, 以类内重构散度最小、类间重构散度最大为目标计算特征字典的最佳低维投影矩阵, 进一步增强低维特征字典的判别性、紧致性; 最后, 提出投影矩阵和稀疏重构关系交替迭代优化算法, 将维数约简过程伴随在稀疏图构建过程中, 使分类效果更理想. 在AR, Extended Yale B, LFW和PubFig这4个数据库上进行大量实验, 验证了本文算法在实验环境数据库和真实环境数据库上的有效性.The unconstrained face images collected in the real environments include many complicated and changeable interference factors, and sparsity preserving projections (SPP) cannot well obtain the low-dimensional intrinsic structure embedded in the high-dimensional samples, which is important for subsequent sparse representation classifier (SRC). To deal with this problem, in this paper we propose a new method named discriminative sparsity graph embedding based on histogram of rotated principal orientation gradients (DSGE-HRPOG). Firstly, it extracts multi-scale and multi-directional gradient features of unconstrained face images by HRPOG feature descriptor and incorporates them into a discriminative feature dictionary of sparse representation classifier. Secondly, it seeks an optimal subspace of HRPOG feature dictionary in which the atoms in intra-classes are as compact as possible, while the atoms in inter-classes are as separable as possible by adopting the proposed DSGE dimensionality reduction method. Finally, an optimal algorithm is presented in which the low-dimensional projection and the sparse graph construction are iteratively updated, and the accuracy of unconstrained face recognition is further improved. Extensive experimental results on AR, Extended Yale B, LFW and PubFig databases demonstrate the effectiveness of our proposed method.

-

Keywords:

- unconstrained face recognition /

- manifold learning /

- sparsity preserving projection /

- histogram of oriented gradients

[1] Qian J J, Luo L, Yang J, Zhang F L, Lin Z C 2015 Pattern Recognit. 48 3145

Google Scholar

Google Scholar

[2] Chen Y, Yang J, Luo L, Zhang H M, Qian J J, Tai Y, Zhang J 2016 Pattern Recognit. 59 26

Google Scholar

Google Scholar

[3] Wright J, Yang A Y, Ganesh A, Sastry S S, Ma Y 2009 IEEE Trans. Pattern Anal. Mach. Intell. 31 210

Google Scholar

Google Scholar

[4] Yang M, Zhang L, Feng X C, Zhang D 2014 Int. J. Comput. Vis. 109 209

Google Scholar

Google Scholar

[5] Vu T H, Monga V 2016 The 23rd IEEE International Conference on Image Processing Phoenix, Arizona, USA, September 25-28, 2016 p4428

[6] Babaee M, Wolf T, Rigoll G 2016 The 23rd IEEE International Conference on Image Processing Phoenix, Arizona, USA, September 25-28, 2016 p704

[7] Huang K K, Dai D Q, Ren C X, Lai Z R 2017 IEEE Trans. Neural Netw. 28 1082

Google Scholar

Google Scholar

[8] Zheng H, Tao D P 2015 Neurocomputing 162 9

Google Scholar

Google Scholar

[9] Cai S J, Zuo W M, Zhang L, Feng X C, Wang P 2014 The 13th European Conference on Computer Vision Zurich, Switzerland, September 6−12, 2014 p624

[10] Yang J M, Yang M H 2017 IEEE Trans. Pattern Anal. Mach. Intell. 39 576

Google Scholar

Google Scholar

[11] Li J, Tao D 2012 IEEE Trans. Image Process. 21 4830

Google Scholar

Google Scholar

[12] Yan Y, Ricci E, Subramanian R 2014 IEEE Trans. Image Process. 23 5599

Google Scholar

Google Scholar

[13] Yang M, Zhang L, Shiu S C K, Zhang D 2013 IEEE Trans. Neural Netw. Learn. Syst. 24 900

Google Scholar

Google Scholar

[14] Yang M, Zhang L, Shiu S C K, Zhang D 2013 Pattern Recognit. 46 1865

Google Scholar

Google Scholar

[15] Georgakis C, Panagakis Y, Pantic M 2016 IEEE Trans. Image Process. 25 2021

Google Scholar

Google Scholar

[16] Zafeiriou S, Tzimiropoulos G, Petrou M, Stathaki T 2012 IEEE Trans. Neural Netw. 23 526

Google Scholar

Google Scholar

[17] Tenenbaum J B, De Silva V, Langford J C 2000 Science 290 2319

Google Scholar

Google Scholar

[18] Roweis S T, Saul L K 2000 Science 290 2323

Google Scholar

Google Scholar

[19] Belkin M, Niyogi P 2003 Neural Comput. 15 1373

Google Scholar

Google Scholar

[20] Lin B B, He X F, Zhang C Y, Ji M 2013 J. Mach. Learn. Res. 14 2945

[21] Lin B B, Yang J, He X F, Ye J P 2014 Int. Conf. Mach. Learn. 145

[22] He X, Niyogi P 2004 Advances in Neural Information Processing Systems 153

[23] He X, Cai D, Yan S 2005 Proc. IEEE Int. Conf. Comput. Vis. 2 1208

[24] Dornaika F, Raduncanu B 2013 The 26th IEEE Conference on Computer Vision and Pattern Recognition Portland, Oregon, USA, Jun 23-28, 2013 p862

[25] Huang S C, Zhuang L 2016 Neurocomputing 218 373

[26] Wan M H, Yang G W, Gai S, Yang Z J 2017 Multimed. Tools Appl. 76 355

Google Scholar

Google Scholar

[27] Liang J Z, Chen C, Yi Y F, Xu X X, Ding M 2017 IEEE Access 17201

[28] Wang R, Nie F P, Hong R C, Chang X J, Yang X J, Yu W Z 2017 IEEE Trans. Image Process. 26 5019

Google Scholar

Google Scholar

[29] Yuan X F, Ge Z Q, Ye L J, Song Z H 2016 J. Chemometr. 30 430

Google Scholar

Google Scholar

[30] Yan S C, Xu D, Zhang B Y, Zhang H J, Yang Q, Lin S 2007 IEEE Trans. Pattern Anal. Mach. Intell. 29 40

Google Scholar

Google Scholar

[31] Belkin M, Niyogi P 2013 Neural Comput. 15 1373

[32] Cortes C, Mohri M 2007 Advances in Neural Information Processing Systems Vancouver, Canada, December 3-8 2007 p305

[33] Qiao L S, Chen S C, Tan X Y 2010 Pattern Recognit. 43 331

Google Scholar

Google Scholar

[34] Lai Z H, Wong W K, Xu Y, Yang J, Zhang D 2016 IEEE Trans. Neural Netw. Learn. Syst. 27 723

Google Scholar

Google Scholar

[35] Yin J, Lai Z H, Zeng W M, Wei L 2018 Multimed. Tools Appl. 77 1069

Google Scholar

Google Scholar

[36] Zhang Y P, Xiang M, Yang B 2016 Neurocomputing 173 518

Google Scholar

Google Scholar

[37] Lu G F, Jin Z, Zou J 2012 Knowl-Based Syst. 31 119

Google Scholar

Google Scholar

[38] Wei L, Xu F F, Wu A H 2014 Knowl-Based Syst. 136

[39] Lou S J, Zhao X M, Chuang Y L, Yu H T, Zhang S Q 2016 Neurocomputing 173 290

Google Scholar

Google Scholar

[40] Yang J, Chu D L, Zhang L, Xu Y, Yang J Y 2013 IEEE Trans. Neural Netw. 24 1023

Google Scholar

Google Scholar

[41] Zheng J W, Yang P, Chen S Y, Shen G J, Wang W L 2017 IEEE Trans. Image Process. 26 2408

Google Scholar

Google Scholar

[42] Gao Q X, Wang Q Q, Huang Y F, Gao X B 2015 IEEE Trans. Image Process. 24 5684

Google Scholar

Google Scholar

[43] Zhang G Q, Sun H J, Xia G Y, Sun Q S 2016 IEEE Trans. Image Process. 25 4271

[44] Ren C X, Dai D Q, Li X X, Lai Z R 2014 IEEE Trans. on Image Processing 23 725

Google Scholar

Google Scholar

[45] Yang M, Zhang L, Shiu S C K, Zhang D 2012 IEEE Trans. on Information Forensics and Security 7 1738

Google Scholar

Google Scholar

[46] Dalal N, Triggs B 2005 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition San Diego, California, June 20-26 2005 p886

[47] Tian S X, Bhattacharya U, Lu S J, Su B L, Wang Q Q, Wei X H, Lu Y, Tan C L 2016 Pattern Recognit. 51 125

Google Scholar

Google Scholar

[48] Tzimiropoulos G, Zafeiriou S, Pantic M 2012 IEEE Trans. Pattern Anal. Mach. Intell. 34 2454

Google Scholar

Google Scholar

[49] Ding C X, Choi J, Tao D C, Davis L S 2016 IEEE Trans. Pattern Anal. Mach. Intell. 38 518

Google Scholar

Google Scholar

[50] Weng D W, Wang Y L, Gong M M, Tao D C 2015 IEEE Trans. Image Process. 24 2287

Google Scholar

Google Scholar

[51] Yin J, Zeng W M, Wei L 2016 Knowl-Based Syst. 99 112

Google Scholar

Google Scholar

[52] Huang K K, Dai D Q, Ren C X 2017 Pattern Recognit. 62 87

Google Scholar

Google Scholar

[53] Liu Y, Gao Q X, Miao S, Gao X B, Nie F, Li Y S 2017 IEEE Trans. Image Process. 26 684

Google Scholar

Google Scholar

[54] Wang H, Nie F P, Huang H 2014 The 31st International Conference on Machine Learning Beijing, China, June 21-26, 2014 p1836

[55] Learned-Miller E, Huang G B, Roy C A, Li H X, Hua G 2016 Advances in Face Detection and Facial Image Analysis. 189

[56] Kumar N, Berg A C, Belhumeur P N, Nayar S K 2009 Proc. IEEE Int. Conf. Comput. Vis. 365

[57] Yang M, Zhang L, Yang J, Zhang D 2013 IEEE Trans. Image Process. 1753

[58] Tang X, Feng G C, Cai J X 2014 Neurocomputing 402

[59] Li F, Jiang M Y 2018 Neural Process. Lett. 47 661

[60] Tao D P, Guo Y N, Li Y T, Gao X B 2018 IEEE Trans. Image Process. 27 325

Google Scholar

Google Scholar

-

表 1 AR数据库在表情、光照和时间干扰因素下的实验结果

Table 1. Experimental results on the AR database with the interference factors of expression, illumination and time.

表 2 AR数据库在遮挡干扰因素下的实验结果

Table 2. Experimental results of AR database with the occlusion interference.

Experiment 1/% Experiment 2/% Experiment 3/% LPP[22] 71.39 68.68 69.46 NPE[23] 72.64 71.81 71.08 SPP[33] 75.90 72.92 74.07 DSNPE[37] 80.28 78.26 78.14 SRC-DP[40] 78.35 76.50 77.80 SRC-FDC[42] 80.90 79.90 80.30 DSGE-pixels 79.03 78.75 82.65 DSGE-HRPOG

(3-HRPOG)88.54 89.51 90.53 DSGE-HRPOG

(5-HRPOG)89.31 89.58 90.98 DSGE-HRPOG

(Ms-HRPOG)89.31 90.00 91.06 表 3 AR数据库在混合干扰因素下的实验结果

Table 3. Experimental results on the AR database with the mix interference factors.

表 4 Extended Yale B数据库在光照干扰因素下的实验结果

Table 4. Experimental results of Extended Yale B database with the illumination interference.

表 5 Extended Yale B数据库在遮挡干扰因素下的实验结果

Table 5. Experimental results of Extended Yale B database with the occlusion interference.

Experiment 1/% Experiment 2/% LPP[22] 95.51 ± 0.40 96.78 ± 0.72 NPE[23] 96.43 ± 0.23 97.85 ± 0.31 SPP[33] 92.57 ± 0.84 93.05 ± 0.77 DSNPE[37] 94.18 ± 0.48 95.29 ± 0.54 Gao[53] 86.91 ± 1.07 88.23 ± 0.91 DSGE-pixels 95.83 ± 0.66 96.21 ± 0.21 DSGE-HRPOG(3-HRPOG) 97.30 ± 0.20 97.73 ± 0.35 DSGE-HRPOG (5-HRPOG) 96.85 ± 0.38 96.93 ± 0.60 DSGE-HRPOG G(Ms-HRPOG) 97.98 ± 0.50 98.10 ± 0.31 表 6 LFW和PubFig数据库的实验结果

Table 6. Experimental results on the LFW database and PubFig database.

表 7 PubFig数据库上有联合优化和无联合优化的实验结果

Table 7. Experimental results with joint optimization and without joint optimization on the PubFig database.

DSGE-HRPOG 3-HRPOG 5-HRPOG Ms-HRPOG with joint optimization 54.20 (630) 53.30 (473) 53.70 (514) without joint optimization 53.50 (514) 50.90 (423) 53.20 (514) -

[1] Qian J J, Luo L, Yang J, Zhang F L, Lin Z C 2015 Pattern Recognit. 48 3145

Google Scholar

Google Scholar

[2] Chen Y, Yang J, Luo L, Zhang H M, Qian J J, Tai Y, Zhang J 2016 Pattern Recognit. 59 26

Google Scholar

Google Scholar

[3] Wright J, Yang A Y, Ganesh A, Sastry S S, Ma Y 2009 IEEE Trans. Pattern Anal. Mach. Intell. 31 210

Google Scholar

Google Scholar

[4] Yang M, Zhang L, Feng X C, Zhang D 2014 Int. J. Comput. Vis. 109 209

Google Scholar

Google Scholar

[5] Vu T H, Monga V 2016 The 23rd IEEE International Conference on Image Processing Phoenix, Arizona, USA, September 25-28, 2016 p4428

[6] Babaee M, Wolf T, Rigoll G 2016 The 23rd IEEE International Conference on Image Processing Phoenix, Arizona, USA, September 25-28, 2016 p704

[7] Huang K K, Dai D Q, Ren C X, Lai Z R 2017 IEEE Trans. Neural Netw. 28 1082

Google Scholar

Google Scholar

[8] Zheng H, Tao D P 2015 Neurocomputing 162 9

Google Scholar

Google Scholar

[9] Cai S J, Zuo W M, Zhang L, Feng X C, Wang P 2014 The 13th European Conference on Computer Vision Zurich, Switzerland, September 6−12, 2014 p624

[10] Yang J M, Yang M H 2017 IEEE Trans. Pattern Anal. Mach. Intell. 39 576

Google Scholar

Google Scholar

[11] Li J, Tao D 2012 IEEE Trans. Image Process. 21 4830

Google Scholar

Google Scholar

[12] Yan Y, Ricci E, Subramanian R 2014 IEEE Trans. Image Process. 23 5599

Google Scholar

Google Scholar

[13] Yang M, Zhang L, Shiu S C K, Zhang D 2013 IEEE Trans. Neural Netw. Learn. Syst. 24 900

Google Scholar

Google Scholar

[14] Yang M, Zhang L, Shiu S C K, Zhang D 2013 Pattern Recognit. 46 1865

Google Scholar

Google Scholar

[15] Georgakis C, Panagakis Y, Pantic M 2016 IEEE Trans. Image Process. 25 2021

Google Scholar

Google Scholar

[16] Zafeiriou S, Tzimiropoulos G, Petrou M, Stathaki T 2012 IEEE Trans. Neural Netw. 23 526

Google Scholar

Google Scholar

[17] Tenenbaum J B, De Silva V, Langford J C 2000 Science 290 2319

Google Scholar

Google Scholar

[18] Roweis S T, Saul L K 2000 Science 290 2323

Google Scholar

Google Scholar

[19] Belkin M, Niyogi P 2003 Neural Comput. 15 1373

Google Scholar

Google Scholar

[20] Lin B B, He X F, Zhang C Y, Ji M 2013 J. Mach. Learn. Res. 14 2945

[21] Lin B B, Yang J, He X F, Ye J P 2014 Int. Conf. Mach. Learn. 145

[22] He X, Niyogi P 2004 Advances in Neural Information Processing Systems 153

[23] He X, Cai D, Yan S 2005 Proc. IEEE Int. Conf. Comput. Vis. 2 1208

[24] Dornaika F, Raduncanu B 2013 The 26th IEEE Conference on Computer Vision and Pattern Recognition Portland, Oregon, USA, Jun 23-28, 2013 p862

[25] Huang S C, Zhuang L 2016 Neurocomputing 218 373

[26] Wan M H, Yang G W, Gai S, Yang Z J 2017 Multimed. Tools Appl. 76 355

Google Scholar

Google Scholar

[27] Liang J Z, Chen C, Yi Y F, Xu X X, Ding M 2017 IEEE Access 17201

[28] Wang R, Nie F P, Hong R C, Chang X J, Yang X J, Yu W Z 2017 IEEE Trans. Image Process. 26 5019

Google Scholar

Google Scholar

[29] Yuan X F, Ge Z Q, Ye L J, Song Z H 2016 J. Chemometr. 30 430

Google Scholar

Google Scholar

[30] Yan S C, Xu D, Zhang B Y, Zhang H J, Yang Q, Lin S 2007 IEEE Trans. Pattern Anal. Mach. Intell. 29 40

Google Scholar

Google Scholar

[31] Belkin M, Niyogi P 2013 Neural Comput. 15 1373

[32] Cortes C, Mohri M 2007 Advances in Neural Information Processing Systems Vancouver, Canada, December 3-8 2007 p305

[33] Qiao L S, Chen S C, Tan X Y 2010 Pattern Recognit. 43 331

Google Scholar

Google Scholar

[34] Lai Z H, Wong W K, Xu Y, Yang J, Zhang D 2016 IEEE Trans. Neural Netw. Learn. Syst. 27 723

Google Scholar

Google Scholar

[35] Yin J, Lai Z H, Zeng W M, Wei L 2018 Multimed. Tools Appl. 77 1069

Google Scholar

Google Scholar

[36] Zhang Y P, Xiang M, Yang B 2016 Neurocomputing 173 518

Google Scholar

Google Scholar

[37] Lu G F, Jin Z, Zou J 2012 Knowl-Based Syst. 31 119

Google Scholar

Google Scholar

[38] Wei L, Xu F F, Wu A H 2014 Knowl-Based Syst. 136

[39] Lou S J, Zhao X M, Chuang Y L, Yu H T, Zhang S Q 2016 Neurocomputing 173 290

Google Scholar

Google Scholar

[40] Yang J, Chu D L, Zhang L, Xu Y, Yang J Y 2013 IEEE Trans. Neural Netw. 24 1023

Google Scholar

Google Scholar

[41] Zheng J W, Yang P, Chen S Y, Shen G J, Wang W L 2017 IEEE Trans. Image Process. 26 2408

Google Scholar

Google Scholar

[42] Gao Q X, Wang Q Q, Huang Y F, Gao X B 2015 IEEE Trans. Image Process. 24 5684

Google Scholar

Google Scholar

[43] Zhang G Q, Sun H J, Xia G Y, Sun Q S 2016 IEEE Trans. Image Process. 25 4271

[44] Ren C X, Dai D Q, Li X X, Lai Z R 2014 IEEE Trans. on Image Processing 23 725

Google Scholar

Google Scholar

[45] Yang M, Zhang L, Shiu S C K, Zhang D 2012 IEEE Trans. on Information Forensics and Security 7 1738

Google Scholar

Google Scholar

[46] Dalal N, Triggs B 2005 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition San Diego, California, June 20-26 2005 p886

[47] Tian S X, Bhattacharya U, Lu S J, Su B L, Wang Q Q, Wei X H, Lu Y, Tan C L 2016 Pattern Recognit. 51 125

Google Scholar

Google Scholar

[48] Tzimiropoulos G, Zafeiriou S, Pantic M 2012 IEEE Trans. Pattern Anal. Mach. Intell. 34 2454

Google Scholar

Google Scholar

[49] Ding C X, Choi J, Tao D C, Davis L S 2016 IEEE Trans. Pattern Anal. Mach. Intell. 38 518

Google Scholar

Google Scholar

[50] Weng D W, Wang Y L, Gong M M, Tao D C 2015 IEEE Trans. Image Process. 24 2287

Google Scholar

Google Scholar

[51] Yin J, Zeng W M, Wei L 2016 Knowl-Based Syst. 99 112

Google Scholar

Google Scholar

[52] Huang K K, Dai D Q, Ren C X 2017 Pattern Recognit. 62 87

Google Scholar

Google Scholar

[53] Liu Y, Gao Q X, Miao S, Gao X B, Nie F, Li Y S 2017 IEEE Trans. Image Process. 26 684

Google Scholar

Google Scholar

[54] Wang H, Nie F P, Huang H 2014 The 31st International Conference on Machine Learning Beijing, China, June 21-26, 2014 p1836

[55] Learned-Miller E, Huang G B, Roy C A, Li H X, Hua G 2016 Advances in Face Detection and Facial Image Analysis. 189

[56] Kumar N, Berg A C, Belhumeur P N, Nayar S K 2009 Proc. IEEE Int. Conf. Comput. Vis. 365

[57] Yang M, Zhang L, Yang J, Zhang D 2013 IEEE Trans. Image Process. 1753

[58] Tang X, Feng G C, Cai J X 2014 Neurocomputing 402

[59] Li F, Jiang M Y 2018 Neural Process. Lett. 47 661

[60] Tao D P, Guo Y N, Li Y T, Gao X B 2018 IEEE Trans. Image Process. 27 325

Google Scholar

Google Scholar

计量

- 文章访问数: 12314

- PDF下载量: 49

- 被引次数: 0

下载:

下载: