-

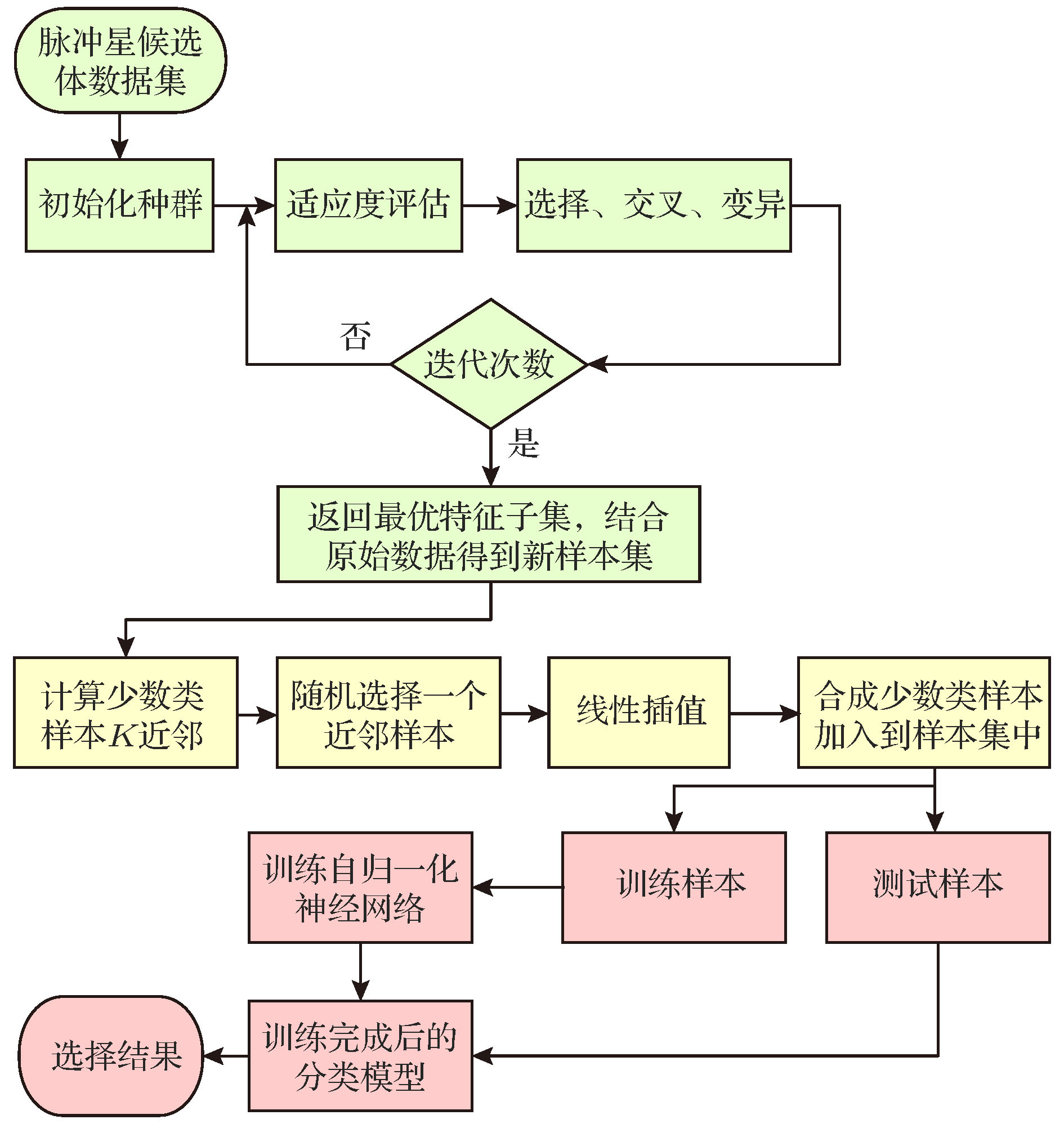

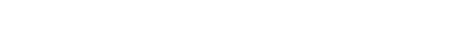

脉冲星候选体选择是脉冲星搜寻任务中的重要步骤. 为了提高脉冲星候选体选择的准确率, 提出了一种基于自归一化神经网络的候选体选择方法. 该方法采用自归一化神经网络、遗传算法、合成少数类过采样这三种技术提升对脉冲星候选体的筛选能力. 利用自归一化神经网络的自归一化性质克服了深层神经网络训练中梯度消失和爆炸的问题, 大大加快了训练速度. 为了消除样本数据的冗余性, 利用遗传算法对脉冲星候选体的样本特征进行选择, 得到了最优特征子集. 针对数据中真实脉冲星样本数极少带来的严重类不平衡性, 采用合成少数类过采样技术生成脉冲星候选体样本, 降低了类不平衡率. 以分类精度为评价指标, 在3个脉冲星候选体数据集上的实验结果表明, 本文提出的方法能有效提升脉冲星候选体选择的性能.Pulsar candidate selection is an important step in the search task of pulsars. The traditional candidate selection is heavily dependent on human inspection. However, the human inspection is a subjective, time consuming, and error-prone process. A modern radio telescopes pulsar survey project can produce totally millions of candidates, so the manual selection becomes extremely difficult and inefficient due to a large number of candidates. Therefore, this study focuses on machine learning developed in recent years. In order to improve the efficiency of pulsar candidate selection, we propose a candidate selection method based on self-normalizing neural networks. This method uses three techniques: self-normalizing neural networks, genetic algorithm and synthetic minority over-sampling technique. The self-normalizing neural networks can improve the identification accuracy by applying deep neural networks to pulsar candidate selection. At the same time, it solves the problem of gradient disappearance and explosion in the training process of deep neural networks by using its self-normalizing property, which greatly accelerates the training process. In addition, in order to eliminate the redundancy of the sample data, we use genetic algorithm to choose sample features of pulsar candidates. The genetic algorithm for feature selection can be summarized into three steps: initializing population, assessing population fitness, and generating new populations. Decoding the individual with the largest fitness value in the last generation population, we can obtain the best subset of features. Due to radio frequency interference or noise, there are a large number of non-pulsar signals in candidates, and only a few real pulsar signals exist there. Aiming at solving the severe class imbalance problem, we use the synthetic minority over-sampling technique to increase the pulsar candidates (minority class) and reduce the imbalance degree of data. By using k-nearest neighbor and linear interpolation to insert a new sample between two minority classes of samples that are close to each other according to certain rules, we can prevent the classifier from becoming biased towards the abundant non-pulsar class (majority class). Experimental results on three pulsar candidate datasets show that the self-normalizing neural network has higher accuracy and faster convergence speed than the traditional artificial neural network in the deep structure, By using the genetic algorithm and synthetic minority over-sampling technique, the selection performance of pulsar candidates can be effectively improved.

-

Keywords:

- pulsar candidate selection /

- self-normalizing neural networks /

- feature selection /

- class imbalance

[1] 孙海峰, 谢楷, 李小平, 方海燕, 刘秀平, 傅灵忠, 孙海建, 薛梦凡 2013 物理学报 62 109701

Google Scholar

Google Scholar

Sun H F, Xie K, Li X P, Fang H Y, Liu X P, Fu L Z, Sun H J, Xue M F 2013 Acta Phys. Sin. 62 109701

Google Scholar

Google Scholar

[2] Heiles C, Li D, Mcclure-Griffiths N, Qian L, Liu S 2019 Res. Astron. Astrophys. 19 5

Google Scholar

Google Scholar

[3] Yi S X, Zhang S N 2016 Sci. China, Phys. Mech. Astron. 59 689511

Google Scholar

Google Scholar

[4] Liu J, Ning X L, Ma X, Fang J C 2019 IEEE Trans. Aerosp. Electron. Syst. 55 2556

Google Scholar

Google Scholar

[5] 康志伟, 吴春艳, 刘劲, 马辛, 桂明臻 2018 物理学报 67 099701

Google Scholar

Google Scholar

Kang Z W, Wu C Y, Liu J, Ma X, Gui M Z 2018 Acta Phys. Sin. 67 099701

Google Scholar

Google Scholar

[6] 房建成, 宁晓琳, 刘劲 2017 航天器自主天文导航原理与技术 (第二版) (北京: 国防工业出版社) 第8页

Fang J C, Ning X L, Liu J 2017 Principles and Methods of Spacecraft Celestial Navigation (2nd Ed.) (Beijing: National Defense Industry Press) p8 (in Chinese)

[7] Hewish A, Bell S J, Pilkington J D H, Scott P F, Collins R A 1968 Nature 217 709

Google Scholar

Google Scholar

[8] Thornton D 2013 Ph. D. Dissertation (Manchester: University of Manchester)

[9] Stovall K, Lynch R S, Ransom S M, et al. 2014 Astrophys. J. 791 67

Google Scholar

Google Scholar

[10] Manchester R N, Lyne A G, Camilo F, Bell J F, Kaspi V M, D'Amico N, McKay N P F, Crawford F, Stairs I H, Possenti A, Kramer M, Sheppard D C 2001 Mon. Not. R. Astron. Soc. 328 17

Google Scholar

Google Scholar

[11] Keith M, Jameson A, Van Straten W, Bailes M, Johnston S, Kramer M, Possenti A, Bates S, Bhat N, Burgay M 2010 Mon. Not. R. Astron. Soc. 409 619

Google Scholar

Google Scholar

[12] van Leeuwen J, Stappers B W 2010 Astron. Astrophys. 509 A7

Google Scholar

Google Scholar

[13] 许余云, 李菂, 刘志杰, 王晨, 王培, 张蕾, 潘之辰 2017 天文学进展 35 304

Google Scholar

Google Scholar

Xu Y Y, Li D, Liu Z J, Wang C, Wang P, Zhang L, Pan Z C 2017 Prog. Astron. 35 304

Google Scholar

Google Scholar

[14] 王元超, 郑建华, 潘之辰, 李明涛 2018 深空探测学报 5 203

Wang Y C, Zheng J H, Pan Z C, Li M T 2018 J. Deep Space Explor. 5 203

[15] Lee K J, Stovall K, Jenet F A, Martinez J, Dartez L P, Mata A, Lunsford G, Cohen S, Biwer C M, Rohr M D 2013 Mon. Not. R. Astron. Soc. 433 688

Google Scholar

Google Scholar

[16] Mohamed T M 2018 Futur. Comput. Inf. J. 3 1

[17] Eatough R P, Molkenthin N, Kramer M, Noutsos A, Keith M J, Stappers B W, Lyne A G 2010 Mon. Not. R. Astron. Soc. 407 2443

Google Scholar

Google Scholar

[18] Bates S D, Bailes M, Barsdell B R, Bhat N D R, Burgay M, Burke-Spolaor S, Champion D J, Coster P, D'Amico N, Jameson A, Johnston S, Keith M J, Kramer M, Levin L, Lyne A, Milia S, Ng C, Nietner C, Possenti A, Stappers B, Thornton D, van Straten W 2012 Mon. Not. R. Astron. Soc. 427 1052

Google Scholar

Google Scholar

[19] Zhu W W, Berndsen A, Madsen E C, et al. 2014 Astrophys. J. 781 117

Google Scholar

Google Scholar

[20] Lyon R J, Stappers B W, Cooper S, Brooke J M, Knowles J D 2016 Mon. Not. R. Astron. Soc. 459 1104

Google Scholar

Google Scholar

[21] Wang H F, Zhu W W, Guo P, Li D, Feng S B, Yin Q, Miao C C, Tao Z Z, Pan Z C, Wang P, Zheng X, Deng X D, Liu Z J, Xie X Y, Yu X H, You S P, Zhang H 2019 Sci. China, Phys. Mech. Astron. 62 959507

Google Scholar

Google Scholar

[22] Klambauer G, Unterthiner T, Mayr A, Hochreiter S 2017 Advances in Neural Information Processing Systems, Long Beach, USA, December 4–9, 2017 p971

[23] Oh I S, Lee J S, Moon B R 2004 IEEE Trans. Pattern Anal. Mach. Intell. 26 1424

Google Scholar

Google Scholar

[24] Chawla N V, Bowyer K W, Hall L O, Kegelmeyer W P 2002 J. Artif. Intell. Res. 16 321

Google Scholar

Google Scholar

[25] Morello V, Barr E D, Bailes M, Flynn C M, Keane E F, van Straten W 2014 Mon. Not. R. Astron. Soc. 443 1651

Google Scholar

Google Scholar

[26] Yao Y, Xin X, Guo P 2016 12th International Conference on Computational Intelligence and Security, Wuxi, China, December 16–19, 2016 p120

[27] Nan R D, Li D, Jin C J, Wang Q M, Zhu L C, Zhu W B, Zhang H Y, Yue Y L, Qian L 2011 Int. J. Mod. Phys. D. 20 989

Google Scholar

Google Scholar

-

表 1 脉冲星候选体数据集

Table 1. Pulsar candidate datasets.

数据集 非脉冲星数 脉冲星数 总样本数 HTRU 1 89996 1196 91192 HTRU 2 16259 1639 17898 LOTAAS 1 4987 66 5053 表 2 特征描述

Table 2. Feature description.

编号 特征 编号 特征 1 P 12 轮廓直方图最大值/高斯拟合的最大值 2 DM 13 对轮廓求导后的直方图与轮廓直方图的偏移量 3 S/N 14 $S/N/\sqrt {\left( {P - W} \right)/W} $ 4 W 15 拟合$S/N/\sqrt {\left( {P - W} \right)/W} $ 5 用sin曲线拟合脉冲轮廓的卡方值 16 DM拟合值与DM最优值取余 6 用sin2曲线拟合脉冲轮廓的卡方值 17 DM曲线拟合的卡方值 7 高斯拟合脉冲轮廓的卡方值 18 峰值处对应的所有频段值的均方根 8 高斯拟合脉冲轮廓的半高宽 19 任意两个频段线性相关度的均值 9 双高斯拟合脉冲轮廓的卡方值 20 线性相关度的和 10 双高斯拟合脉冲轮廓的平均半高宽 21 脉冲轮廓的波峰数 11 脉冲轮廓直方图对0的偏移量 22 脉冲轮廓减去均值后的面积 表 3 不同隐藏层数下的分类效果

Table 3. Classification results with the different hidden layers.

隐藏层数 F1-score/% 2 82.48 4 89.58 8 94.56 9 94.20 表 4 不同批次大小下的分类效果

Table 4. Classification results with the different batch size.

批次大小 F1-score/% 运行时间/s 16 94.87 74 32 94.56 43 64 93.90 23 128 91.05 11 表 5 不同学习速率的分类效果

Table 5. Classification results with the different learning rates.

隐藏层数 F1-score/% 0.1 无法收敛 0.01 94.29 0.001 94.55 0.0001 84.10 表 6 不同方法在3个数据集上的分类效果

Table 6. Classification results with different methods on three datasets.

数据集 模型 Accuracy/% Recall/% Precison/% F1-score/% FPR/% G-mean/% HTRU 1 SNN 99.82 92.44 93.45 92.94 0.08 96.11 GA_SNN 99.85 92.45 95.19 93.80 0.06 96.12 MO_SNN 99.81 94.23 97.94 96.05 0.05 97.05 GMO_SNNNNNNNNN 99.85 95.32 98.51 96.89 0.04 97.61 HTRU 2 SNN 98.30 87.73 93.93 90.73 0.59 93.38 GA_SNN 98.30 88.91 92.86 90.84 0.71 93.96 MO_SNN 97.89 92.17 95.08 93.60 0.95 95.54 GMO_SNNNNNNNNN 98.03 92.53 95.58 94.03 0.08 95.78 LOTAAS 1 SNN 99.92 93.75 100.00 96.77 0.08 96.79 GA_SNN 99.92 100.00 93.33 96.55 0 100.00 MO_SNN 99.69 100.00 87.10 93.10 0.31 99.84 GMO_SNN 100.00 100.00 100.00 100.00 0 100.00 -

[1] 孙海峰, 谢楷, 李小平, 方海燕, 刘秀平, 傅灵忠, 孙海建, 薛梦凡 2013 物理学报 62 109701

Google Scholar

Google Scholar

Sun H F, Xie K, Li X P, Fang H Y, Liu X P, Fu L Z, Sun H J, Xue M F 2013 Acta Phys. Sin. 62 109701

Google Scholar

Google Scholar

[2] Heiles C, Li D, Mcclure-Griffiths N, Qian L, Liu S 2019 Res. Astron. Astrophys. 19 5

Google Scholar

Google Scholar

[3] Yi S X, Zhang S N 2016 Sci. China, Phys. Mech. Astron. 59 689511

Google Scholar

Google Scholar

[4] Liu J, Ning X L, Ma X, Fang J C 2019 IEEE Trans. Aerosp. Electron. Syst. 55 2556

Google Scholar

Google Scholar

[5] 康志伟, 吴春艳, 刘劲, 马辛, 桂明臻 2018 物理学报 67 099701

Google Scholar

Google Scholar

Kang Z W, Wu C Y, Liu J, Ma X, Gui M Z 2018 Acta Phys. Sin. 67 099701

Google Scholar

Google Scholar

[6] 房建成, 宁晓琳, 刘劲 2017 航天器自主天文导航原理与技术 (第二版) (北京: 国防工业出版社) 第8页

Fang J C, Ning X L, Liu J 2017 Principles and Methods of Spacecraft Celestial Navigation (2nd Ed.) (Beijing: National Defense Industry Press) p8 (in Chinese)

[7] Hewish A, Bell S J, Pilkington J D H, Scott P F, Collins R A 1968 Nature 217 709

Google Scholar

Google Scholar

[8] Thornton D 2013 Ph. D. Dissertation (Manchester: University of Manchester)

[9] Stovall K, Lynch R S, Ransom S M, et al. 2014 Astrophys. J. 791 67

Google Scholar

Google Scholar

[10] Manchester R N, Lyne A G, Camilo F, Bell J F, Kaspi V M, D'Amico N, McKay N P F, Crawford F, Stairs I H, Possenti A, Kramer M, Sheppard D C 2001 Mon. Not. R. Astron. Soc. 328 17

Google Scholar

Google Scholar

[11] Keith M, Jameson A, Van Straten W, Bailes M, Johnston S, Kramer M, Possenti A, Bates S, Bhat N, Burgay M 2010 Mon. Not. R. Astron. Soc. 409 619

Google Scholar

Google Scholar

[12] van Leeuwen J, Stappers B W 2010 Astron. Astrophys. 509 A7

Google Scholar

Google Scholar

[13] 许余云, 李菂, 刘志杰, 王晨, 王培, 张蕾, 潘之辰 2017 天文学进展 35 304

Google Scholar

Google Scholar

Xu Y Y, Li D, Liu Z J, Wang C, Wang P, Zhang L, Pan Z C 2017 Prog. Astron. 35 304

Google Scholar

Google Scholar

[14] 王元超, 郑建华, 潘之辰, 李明涛 2018 深空探测学报 5 203

Wang Y C, Zheng J H, Pan Z C, Li M T 2018 J. Deep Space Explor. 5 203

[15] Lee K J, Stovall K, Jenet F A, Martinez J, Dartez L P, Mata A, Lunsford G, Cohen S, Biwer C M, Rohr M D 2013 Mon. Not. R. Astron. Soc. 433 688

Google Scholar

Google Scholar

[16] Mohamed T M 2018 Futur. Comput. Inf. J. 3 1

[17] Eatough R P, Molkenthin N, Kramer M, Noutsos A, Keith M J, Stappers B W, Lyne A G 2010 Mon. Not. R. Astron. Soc. 407 2443

Google Scholar

Google Scholar

[18] Bates S D, Bailes M, Barsdell B R, Bhat N D R, Burgay M, Burke-Spolaor S, Champion D J, Coster P, D'Amico N, Jameson A, Johnston S, Keith M J, Kramer M, Levin L, Lyne A, Milia S, Ng C, Nietner C, Possenti A, Stappers B, Thornton D, van Straten W 2012 Mon. Not. R. Astron. Soc. 427 1052

Google Scholar

Google Scholar

[19] Zhu W W, Berndsen A, Madsen E C, et al. 2014 Astrophys. J. 781 117

Google Scholar

Google Scholar

[20] Lyon R J, Stappers B W, Cooper S, Brooke J M, Knowles J D 2016 Mon. Not. R. Astron. Soc. 459 1104

Google Scholar

Google Scholar

[21] Wang H F, Zhu W W, Guo P, Li D, Feng S B, Yin Q, Miao C C, Tao Z Z, Pan Z C, Wang P, Zheng X, Deng X D, Liu Z J, Xie X Y, Yu X H, You S P, Zhang H 2019 Sci. China, Phys. Mech. Astron. 62 959507

Google Scholar

Google Scholar

[22] Klambauer G, Unterthiner T, Mayr A, Hochreiter S 2017 Advances in Neural Information Processing Systems, Long Beach, USA, December 4–9, 2017 p971

[23] Oh I S, Lee J S, Moon B R 2004 IEEE Trans. Pattern Anal. Mach. Intell. 26 1424

Google Scholar

Google Scholar

[24] Chawla N V, Bowyer K W, Hall L O, Kegelmeyer W P 2002 J. Artif. Intell. Res. 16 321

Google Scholar

Google Scholar

[25] Morello V, Barr E D, Bailes M, Flynn C M, Keane E F, van Straten W 2014 Mon. Not. R. Astron. Soc. 443 1651

Google Scholar

Google Scholar

[26] Yao Y, Xin X, Guo P 2016 12th International Conference on Computational Intelligence and Security, Wuxi, China, December 16–19, 2016 p120

[27] Nan R D, Li D, Jin C J, Wang Q M, Zhu L C, Zhu W B, Zhang H Y, Yue Y L, Qian L 2011 Int. J. Mod. Phys. D. 20 989

Google Scholar

Google Scholar

计量

- 文章访问数: 11355

- PDF下载量: 125

- 被引次数: 0

下载:

下载: