-

行人跟踪是计算机视觉领域中研究的热点和难点, 通过对视频资料中行人的跟踪, 可以提取出行人的运动轨迹, 进而分析个体或群体的行为规律. 本文首先对行人跟踪与行人检测问题之间的差别进行了阐述, 其次从传统跟踪算法和基于深度学习的跟踪算法两个方面分别综述了相关算法与技术, 并对经典的行人动力学模型进行了介绍, 最终对行人跟踪在智能监控、拥堵人群分析、异常行为检测等场景的应用进行了系统讲解. 在深度学习浪潮席卷计算机视觉领域的背景下, 行人跟踪领域的研究取得了飞跃式发展, 随着深度学习算法在计算机视觉领域的应用日益成熟, 利用这一工具提取和量化个体和群体的行为模式, 进而对大规模人群行为开展精确、实时的分析成为了该领域的发展趋势.Pedestrian tracking is a hotspot and a difficult topic in computer vision research. Through the tracking of pedestrians in video materials, trajectories can be extracted to support the analysis of individual or collected behavior dynamics. In this review, we first discuss the difference between pedestrian tracking and pedestrian detection. Then we summarize the development of traditional tracking algorithms and deep learning-based tracking algorithms, and introduce classic pedestrian dynamic models. In the end, typical applications, including intelligent monitoring, congestion analysis, and anomaly detection are introduced systematically. With the rising use of big data and deep learning techniques in the area of computer vision, the research on pedestrian tracking has made a leap forward, which can support more accurate, timely extraction of behavior patterns and then to facilitate large-scale dynamic analysis of individual or crowd behavior.

[1] Wang C, Sun X, Li H 2019 J. Phys. 1176 032028

[2] 李海翔 2018 硕士学位论文 (合肥: 中国科学技术大学)

Li H X 2018 M.S. Thesis (Hefei: University of Science and Technology of China) (in Chinese)

[3] 黄忠主 2011 硕士学位论文 (长沙: 国防科学技术大学)

Hang Z Z 2011 M.S. Thesis (Changsha: National University of Defense Technology) (in Chinese)

[4] Li X, Hu W, Shen C, Zhang Z, Dick A, Hengel A 2013 ACM Trans. Intell. Syst. Technol. 4 58

[5] 闫小勇 2011 电子科技大学学报 40 168

Google Scholar

Google Scholar

Yan X Y 2011 J. Univ. Electron. Sci. Technol. China 40 168

Google Scholar

Google Scholar

[6] 韩筱璞, 汪秉宏, 周涛 2010 复杂系统与复杂性科学 07 132

Google Scholar

Google Scholar

Han X P, Wang B H, Zhou T 2010 Complex Syst. Complex. Sci. 07 132

Google Scholar

Google Scholar

[7] Zhang S, Yao H, Sun X, Lu X 2013 Pattern Recogn. 46 1772

Google Scholar

Google Scholar

[8] Zhang K, Song H 2013 Pattern Recogn. 46 397

Google Scholar

Google Scholar

[9] Zhang S, Wang J, Wang Z, Gong Y, Liu Y 2015 Pattern Recogn. 48 580

Google Scholar

Google Scholar

[10] 魏然 2014 硕士学位论文 (哈尔滨: 哈尔滨工程大学)

Wei R 2014 M.S. Thesis (Harbin: Harbin Engineering University) (in Chinese)

[11] Brunetti A, Buongiorno D, Trotta G F, Bevilacqua V 2018 Neurocomputing 300 17

Google Scholar

Google Scholar

[12] Kalman R E 1960 J. Basic. Eng. 82 35

Google Scholar

Google Scholar

[13] Comaniciu D, Ramesh V, Meer P 2003 IEEE Trans. Pattern Anal. Mach. Intell. 5 564

[14] Bishop G, Welch G 2001 Proceedings of SIGGRAPH 2001 Los Angeles, August 12–17, 2001 p41

[15] Chui C K, Chen G 2017 Kalman Filtering (New York: Springer) pp19−26

[16] Huang S, Hong J 2011 International Conference on Consumer Electronics, Communications and Networks Xianning, China, March 11−13, 2011 p1423

[17] 王慧 2018 电脑知识与技术 14 0194

Wang H 2018 Comput. Know. Tech. 14 0194

[18] 李娟, 邵春福, 杨励雅, 李琦 2009 交通运输系统工程与信息 9 0148

Li J, Shao C F, Yang L Y, Li Q 2009 J. Transp. Syst. Eng. Inf. Tech. 9 0148

[19] 石龙伟 2017 硕士学位论文(重庆: 重庆邮电大学)

Shi L W 2017 M.S. Thesis (Chongqing: Chongqing University of Posts and Telecommunications) (in Chinese)

[20] 王宏选 2017 硕士学位论文(西安: 西安电子科技大学)

Wang X H 2017 M.S. Thesis (Xian: Xidian University) (in Chinese)

[21] Reid D 1979 IEEE Trans. Autom. Control 24 843

Google Scholar

Google Scholar

[22] Kim C, Li F, Ciptadi A, Rehg J M 2015 IEEE International Conference on Computer Vision Santiago, Chile, December 13–16, 2015 p4696

[23] Kim C, Li F, Rehg J M 2018 European Conference on Computer Vision Munich, Germany, September 8−14, 2018 p200

[24] 翟海涛 2010 信息化研究 36 25

Zhai T H 2010 Inf. Res. 36 25

[25] Finn L, Kingston P 2019 Proceedings of the IEEE Aerospace Big Sky, Montana, March 2−9, 2019 p1

[26] Yilmaz A, Javed O, Shah M 2006 ACM Comput. Surv. 38 13

Google Scholar

Google Scholar

[27] Breitenstein M D, Reichlin F, Leibe B, Koller-Meier E, Van Gool L 2010 IEEE Trans. Pattern Anal. Mach. Intell. 33 1820

[28] Gordon N J, Salmond D J, Smith A F 1993 IEE Proc. F. 140 107

[29] Breitenstein M D, Reichlin F, Leibe B, Koller-Meier E, Van Gool L 2009 IEEE International Conference on Computer Vision Kyoto, Japan, September 29−October 2, 2009 p1515

[30] Xu R, Guan Y, Huang Y 2015 Multimed. Tools. Appl. 74 729

Google Scholar

Google Scholar

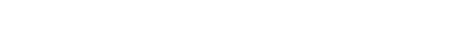

[31] Xiang Y, Alahi A, Savarese S 2015 IEEE International Conference on Computer Vision Santiago, Chile, December 13−16, 2015 p4705

[32] White C 2001 Markov Decision Processes (New York: Springer) pp32−40

[33] Bolme D S, Beveridge J R, Draper B A, Lui Y M 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition San Francisco, CA, June 13−18, 2019 p2544

[34] Henriques J F, Caseiro R, Martins P, Batista J 2015 IEEE Trans. Pattern Anal. Mach. Intell. 37 583

Google Scholar

Google Scholar

[35] Henriques J F, Caseiro R, Martins P, Batista J 2012 European Conference on Computer Vision Firenze, Italy, October 7−13, 2012 p702

[36] 王松 2017 硕士学位论文 (杭州: 浙江大学)

Wang S 2017 M.S. Thesis (Hangzhou: Zhejiang University) (in Chinese)

[37] 邓雪菲, 彭先容, 张建林, 徐智勇 2019 光电技术及应用 40 742

Deng X F, Peng X Y, Zhang J L, Xu Z Y 2019 Semiconduct. Optoelectron. 40 742

[38] 周飞燕, 金林鹏, 董军 2019 计算机学报 40 1229

Zhou F Y, Jin L P, Dong J 2019 Chin. J. Comput. 40 1229

[39] Marcus G 2018 arXiv: 1801.00631[cs]

[40] Goodfellow I, Bengio Y, Courville A 2016 Deep Learning (London: MIT press) pp10−15

[41] Luo W, Xing J, Milan A, Zhang X, Liu W, Zhao X, Kim T K 2014 arXiv: 1409.7618 [cs]

[42] LeCun Y 1989 Connectionism in Perspective (North Holland: Citeseer) pp23−25

[43] Krizhevsky A, Sutskever I, Hinton G E 2012 Advances in Neural Information Processing Systems Lake Tahoe, Nevada, December 3−6, 2012 p1097

[44] LeCun Y, Bottou L, Bengio Y, Haffner P 1998 Proceedings of the IEEE Leuven, Belgium, May 20−20, 1998 p2278

[45] Girshick R, Donahue J, Darrell T, Malik J 2014 IEEE Conference on Computer Vision and Pattern Recognition Columbus, Ohio, June 24−27, 2014 p580

[46] Uijlings J R, Van De Sande K E, Gevers T, Smeulders A W 2013 Int. J. Comput. Vis. 104 154

Google Scholar

Google Scholar

[47] Ren S, He K, Girshick R, Sun J 2015 IEEE Trans. Pattern Anal. Mach. Intell. 39 1137

[48] He K, Zhang X, Ren S, Sun J 2014 IEEE Trans. Pattern Anal. Mach. Intell. 37 1904

[49] Li Y, Hu J, Ji B 2019 Journal of Physics: Conference Series p022119

[50] 陈怡佳 2019 硕士学位论文 (哈尔滨: 哈尔滨理工大学)

Chen Y J 2019 M.S. Thesis (Harbin: Harbin University of Science and Technology) (in Chinese)

[51] 聂文昌 2019 硕士学位论文 (哈尔滨: 哈尔滨工程大学)

Nie W C 2019 M.S. Thesis (Harbin: Harbin Engineering University) (in Chinese)

[52] Redmon J, Divvala S, Girshick R, Farhadi A 2016 IEEE Conference on Computer Vision and Pattern Recognition Las Vegas, Nevada, June 26−July 1, 2016 p779

[53] Mittal N, Akarsh V, Kapoor S 2019 Int. J. Sci. Res. Eng. Trends 5 562

[54] Szegedy C, Liu W, Jia Y, Sermanet P, Reed S, Anguelov D, Erhan D, Vanhoucke V, Rabinovich A 2015 IEEE Conference on Computer Vision and Pattern Recognition Boston, Massachusetts, June 8−10, 2015 p1

[55] 杨眷玉 2016 硕士学位论文 (成都: 电子科技大学)

Yang J Y 2019 M.S. Thesis (Chengdu: University of Electronic Science and Technology of China) (in Chinese)

[56] Redmon J, Farhadi A 2017 IEEE Conference on Computer Vision and Pattern Recognition Honolulu, HI, July 21−26, 2017 p7263

[57] Redmon J, Farhadi A 2018 arXiv: 1804.02767[cs]

[58] Lin T Y, Goyal P, Girshick R, He K, Dollár P 2017 IEEE International Conference on Computer Vision Venice, Italy, October 22−29, 2017 p2980

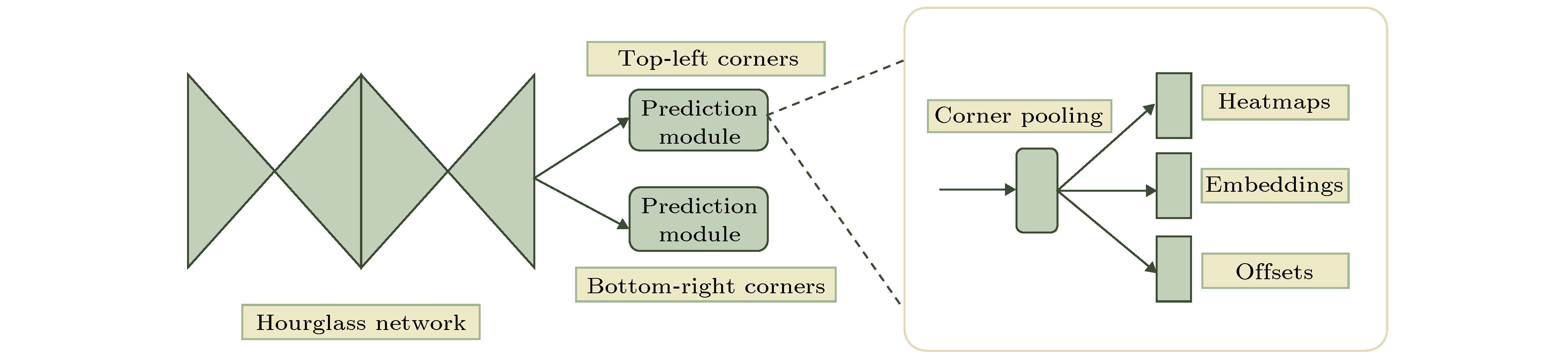

[59] Law H, Deng J 2018 European Conference on Computer Vision Munich, Germany, September 8−14, 2018 p734

[60] Zhou X, Wang D, Krähenbühl P 2019 arXiv: 1904.07850[cs]

[61] Duan K, Bai S, Xie L, Qi H, Huang Q, Tian Q 2019 IEEE International Conference on Computer Vision Seoul, Korea, October 27−November 2, 2019 p6569

[62] Bernardin K, Stiefelhagen R 2008 Eurasip J. Image Vide. 2008 246309

[63] Leal-Taixé L, Milan A, Reid I, Roth S, Schindler K 2015 arXiv: 1504.01942[cs]

[64] Shantaiya S, Verma K, Mehta K 2015 Eur. J. Adv. Eng. Tech. 2 34

[65] Yang Y, Bilodeau G A 2017 Proceedings of the Computer and Robot Vision Edmonton, Canada, May 16−19, 2017 p209

[66] Chen L, Ai H, Shang C, Zhuang Z, Bai B 2017 IEEE International Conference on Image Beijing, China, September 17−20, 2017 p645

[67] Yi Z, Shen Y, Zhao Q 2019 Optik 194 163124

Google Scholar

Google Scholar

[68] 周涛, 韩筱璞, 闫小勇, 杨紫陌, 赵志丹, 汪秉宏 2013 电子科技大学学报 42 481

Google Scholar

Google Scholar

Zhou T, Han P X, Yan Y X, Yang Z M, Zhao Z D, Wang B H 2013 J. Univ. Electron. Sci. Technol. China 42 481

Google Scholar

Google Scholar

[69] Barbosa H, Barthelemy M, Ghoshal G, James C R, Lenormand M, Louail T, Menezes R, Ramasco J J, Simini F, Tomasini M 2018 Phys. Rep. 734 1

Google Scholar

Google Scholar

[70] Yan X Y, Wang W X, Gao Z Y, Lai Y C 2017 Nat. Commun. 8 1639

Google Scholar

Google Scholar

[71] Henderson L F 1974 Transp. Res. 8 509

Google Scholar

Google Scholar

[72] Henderson L 1971 Nature 229 381

Google Scholar

Google Scholar

[73] Henderson L, Lyons D 1972 Nature 240 353

Google Scholar

Google Scholar

[74] Henderson L, Jenkins D 1974 Transp. Res. 8 71

Google Scholar

Google Scholar

[75] Helbing D 1998 Complex Syst. 6 391

[76] Alberti E, Belli G 1978 Transp. Res. 12 33

Google Scholar

Google Scholar

[77] Helbing D 1991 Behav. Sci. 36 298

Google Scholar

Google Scholar

[78] Keizer J 2012 Statistical Thermodynamics of Nonequilibrium Processes (New York: Springer) pp22−34

[79] Helbing D 1992 Physica A 181 29

Google Scholar

Google Scholar

[80] Haase K, Kasper M, Koch M, Müller S 2019 Oper. Res. 67 376

[81] Dong H, Zhou M, Wang Q, Yang X, Wang F Y 2019 IEEE Trans. Intell. Transp. Syst. DOI: 10.1109/TITS.2019.2915014

[82] Johansson A, Helbing D, Shukla P K 2007 Adv. Complex Syst. 10 271

[83] Frank G A, Dorso C O 2011 Physica A 390 2135

Google Scholar

Google Scholar

[84] Moussaïd M, Helbing D, Theraulaz G 2011 Proc. Natl. Acad. Sci. U.S.A. 108 6884

Google Scholar

Google Scholar

[85] Gibson J J 1958 Br. J. Psychol. 49 182

Google Scholar

Google Scholar

[86] Batty M 1997 Nature 388 19

Google Scholar

Google Scholar

[87] Turner A, Penn A 2002 Environ. Plann. B Plann. Des. 29 473

[88] Porter E, Hamdar S H, Daamen W 2018 Transp. 14 361

[89] Collins R T, Lipton A J, Kanade T 2000 IEEE Trans. Pattern Anal. Mach. Intell. 22 745

Google Scholar

Google Scholar

[90] Ferrando S, Gera G, Regazzoni C 2006 IEEE International Conference on Video and Signal Based Surveillance Sydney, Australia, November 22−24, 2006 p21

[91] 刘晓冬, 苏光大, 周全, 田超 2019 中国图像图形学报 5 1024

Liu X D, Su G D, Zhou Q, Tian C 2019 J. Image Graph. 5 1024

[92] 万琴, 王耀南 2007 计算机应用研究 1 199

Google Scholar

Google Scholar

Wang Q, Wang N Y 2007 Appl. Res. Comput. 1 199

Google Scholar

Google Scholar

[93] Nikouei S Y, Chen Y, Faughnan T R 2018 Proceedings of the IEEE/ACM Symposium on Edge Computing Bellevue, WA, October 25−27, 2018 p336

[94] Gajjar V, Gurnani A, Khandhediya Y 2017 IEEE International Conference on Computer Vision Venice, Italy, October 22−29, 2017 p2805

[95] Helbing D, Frankas I, Vicsek T 2000 Nature 407 487

Google Scholar

Google Scholar

[96] Helbing D 2013 Nature 497 51

Google Scholar

Google Scholar

[97] Haghani M, Sarvi M 2017 Transp. Res. B Meth. 107 253

[98] Zawbaa H M, Aly S A, Gutub A A 2012 arXiv: 1209.3433[cs]

[99] Helbing D, Johansson A, Zein H, Abideen A 2007 Phys. Rev. E 75 046109

Google Scholar

Google Scholar

[100] Zhao Y, Li M, Xin L, Tian L, Yu Z, Kai H, Wang Y, Li T 2017 Physica A 465 175

Google Scholar

Google Scholar

[101] 汪秉宏, 周涛, 史冬梅 2016 现代物理知识 28 50

Wang B H, Zhou T, Shi D M 2016 Mod. Phys. 28 50

[102] Yogameena B, Nagananthini C 2017 Int. J. Disast. Risk. Re. 22 95

[103] Miaou S G, Sung P H, Huang C Y 2006 Proceedings of the Distributed Diagnosis and Home Healthcare Arlington, VA, April 2−4, 2006 p39

[104] Zhu J, Javed O, Liu J, Qian Y, Sawhney H 2014 IEEE Conference on Computer Vision and Pattern Recognition Columbus, Ohio, Jun 24−27, 2014 p3510

[105] Kocabas M, Karagoz S, Akbas E 2018 European Conference on Computer Vision Munich, Germany, September 8−14, 2018 p417

[106] Lu X, Wrathall D J, Sundsøy P R, Nadiruzzaman M, Wetter E, Iqbal A, Qureshi T, Tatem A J, Canright G S, Engø-Monsen K 2016 Clim. Change 138 505

Google Scholar

Google Scholar

[107] Lu X, Wrathall D J, Sundsøy P R, Nadiruzzaman M, Wetter E, Iqbal A, Qureshi T, Tatem A, Canright G, Engø-Monsen K 2016 Glob. Environ. Change 38 1

Google Scholar

Google Scholar

[108] Lu X, Bengtsson L, Holme P 2012 Proc. Natl. Acad. Sci. U.S.A. 109 11576

Google Scholar

Google Scholar

[109] Lu X, Wetter E, Bharti N, Tatem A J, Bengtsson L 2013 Sci. Rep. 3 2923

Google Scholar

Google Scholar

[110] Gonzalez M C, Hidalgo C A, Barabasi A L 2008 Nature 453 779

Google Scholar

Google Scholar

[111] Lu X, Brelsford C 2014 Sci. Rep. 4 6773

[112] Huang G, Cai M, Lu X 2019 Inter. J. Environ. Res. Pub. Heal. 16 3597

Google Scholar

Google Scholar

[113] 吕欣 2018 中国计算机学会通讯 14 56

Lu X 2018 Commun. CCF 14 56

-

表 1 卡尔曼滤波的预测阶段和更新阶段

Table 1. Prediction and update process of Kalman filtering

预测阶段 更新阶段 $\hat { x}_k^ - \!=\! { A}\hat { x}_{k-1}^ - \!+\! { B}{ U_{k - 1} }$ ${ { K}_k} \!=\! { P}_k^ - { { H}^{\rm T} }{({ {HP} }_k^ - { { H}^{\rm T} } \!+\! { R})^{ - 1} }$ ${ P}_k^ - \!=\! { A}{ { P}_{k - 1} }{ { A}^T} \!+\! { Q}$ ${ {\hat { x} }_k} \!=\! \hat { x}_k^ - \!+\! { { K}_k}({ { y}_k} \!-\! { H}\hat { x}_k^ - )$ ${{ P}_k} = ({ I} - {{ K}_k}{ H}){ P}$ 表 2 卡尔曼滤波公式中的参数及含义

Table 2. Parameters and meanings in the Kalman filter formula

参数 含义 $\hat { x}_k^-$ 目标在$k$时刻的先验状态估计值, 包括目标的位置、速度等参数, 一般是$n$维向量 ${ {\hat { x}}_k}$ 目标在$k$时刻的后验状态估计值, 是对$\hat { x}_k^-$应用卡尔曼滤波更新后的值 ${{\hat { x}}_{k - 1}}$ 目标在$k-1$时刻的后验状态估计值 ${ A}$ 状态转移矩阵, 一般是$n \times n$阶的方阵 ${ B}$ 控制矩阵, 一般为0 ${ U}_{k-1}$ 外部控制量, 一般也为0 ${ P}_k^-$ $k$时刻的先验误差协方差矩阵, 需要事先给定一个初始值, 以后的值可以由卡尔曼滤波递归得到 ${ P}_k$ $k$时刻的后验误差协方差矩阵, 是对${ P}_k^-$的修正 ${ K}_k$ 卡尔曼增益 ${ y}_k$ 测量值, 一般只能测量目标的位置, 是$m$维向量 ${ Q}$ 系统噪声协方差矩阵, 是一个需要调节的参数, 一般假定它是一个固定的值, 在实验中需要通过不断

调节$Q$值, 来寻找滤波器的最优值${ R}$ 观测噪声协方差矩阵, 和测量仪器有关, 在实验中要不断尝试来确定最优的${ R}$值 ${ H}$ 观测矩阵, 是$m \times n$阶矩阵, 用于将$m$维的测量值${ y}_k$转换为与预测值${{\hat { x}}_k}$相同的$n$维向量 表 3 不同算法之间的性能对比

Table 3. Performance comparison between different algorithms

算法 MOTA↑ MOTP↑ MT↑ ML↓ IDS↓ 数据集 类别 卡尔曼滤波[64] 85.00% — — — — MIT Traffic video dataset 传统跟踪算法 多假设跟踪算法[21] 29.10% 71.70% 12.10% 53.30% 476 MOT Benchmark 传统跟踪算法 粒子滤波算法[27] — — 80.80% 0.70% 10 CAVIAR dateset 传统跟踪算法 基于马尔科夫决策的

多目标跟踪算法[31]30.30% 71.30% 13.00% 38.40% 680 MOT Benchmark 传统跟踪算法 相关滤波算法[65] 83.40% 73.50% — — — Urban Tracker dataset 传统跟踪算法 基于Faster-RCNN的跟踪算法[66] 38.50% 72.60% 8.70% 37.40% 586 MOT 15 Benchmark 深度学习跟踪算法 基于YOLOV3的跟踪算法[67] 60.50% 79.30% 30.20% 19.60% 1129 MOT 16 Benchmark 深度学习跟踪算法 -

[1] Wang C, Sun X, Li H 2019 J. Phys. 1176 032028

[2] 李海翔 2018 硕士学位论文 (合肥: 中国科学技术大学)

Li H X 2018 M.S. Thesis (Hefei: University of Science and Technology of China) (in Chinese)

[3] 黄忠主 2011 硕士学位论文 (长沙: 国防科学技术大学)

Hang Z Z 2011 M.S. Thesis (Changsha: National University of Defense Technology) (in Chinese)

[4] Li X, Hu W, Shen C, Zhang Z, Dick A, Hengel A 2013 ACM Trans. Intell. Syst. Technol. 4 58

[5] 闫小勇 2011 电子科技大学学报 40 168

Google Scholar

Google Scholar

Yan X Y 2011 J. Univ. Electron. Sci. Technol. China 40 168

Google Scholar

Google Scholar

[6] 韩筱璞, 汪秉宏, 周涛 2010 复杂系统与复杂性科学 07 132

Google Scholar

Google Scholar

Han X P, Wang B H, Zhou T 2010 Complex Syst. Complex. Sci. 07 132

Google Scholar

Google Scholar

[7] Zhang S, Yao H, Sun X, Lu X 2013 Pattern Recogn. 46 1772

Google Scholar

Google Scholar

[8] Zhang K, Song H 2013 Pattern Recogn. 46 397

Google Scholar

Google Scholar

[9] Zhang S, Wang J, Wang Z, Gong Y, Liu Y 2015 Pattern Recogn. 48 580

Google Scholar

Google Scholar

[10] 魏然 2014 硕士学位论文 (哈尔滨: 哈尔滨工程大学)

Wei R 2014 M.S. Thesis (Harbin: Harbin Engineering University) (in Chinese)

[11] Brunetti A, Buongiorno D, Trotta G F, Bevilacqua V 2018 Neurocomputing 300 17

Google Scholar

Google Scholar

[12] Kalman R E 1960 J. Basic. Eng. 82 35

Google Scholar

Google Scholar

[13] Comaniciu D, Ramesh V, Meer P 2003 IEEE Trans. Pattern Anal. Mach. Intell. 5 564

[14] Bishop G, Welch G 2001 Proceedings of SIGGRAPH 2001 Los Angeles, August 12–17, 2001 p41

[15] Chui C K, Chen G 2017 Kalman Filtering (New York: Springer) pp19−26

[16] Huang S, Hong J 2011 International Conference on Consumer Electronics, Communications and Networks Xianning, China, March 11−13, 2011 p1423

[17] 王慧 2018 电脑知识与技术 14 0194

Wang H 2018 Comput. Know. Tech. 14 0194

[18] 李娟, 邵春福, 杨励雅, 李琦 2009 交通运输系统工程与信息 9 0148

Li J, Shao C F, Yang L Y, Li Q 2009 J. Transp. Syst. Eng. Inf. Tech. 9 0148

[19] 石龙伟 2017 硕士学位论文(重庆: 重庆邮电大学)

Shi L W 2017 M.S. Thesis (Chongqing: Chongqing University of Posts and Telecommunications) (in Chinese)

[20] 王宏选 2017 硕士学位论文(西安: 西安电子科技大学)

Wang X H 2017 M.S. Thesis (Xian: Xidian University) (in Chinese)

[21] Reid D 1979 IEEE Trans. Autom. Control 24 843

Google Scholar

Google Scholar

[22] Kim C, Li F, Ciptadi A, Rehg J M 2015 IEEE International Conference on Computer Vision Santiago, Chile, December 13–16, 2015 p4696

[23] Kim C, Li F, Rehg J M 2018 European Conference on Computer Vision Munich, Germany, September 8−14, 2018 p200

[24] 翟海涛 2010 信息化研究 36 25

Zhai T H 2010 Inf. Res. 36 25

[25] Finn L, Kingston P 2019 Proceedings of the IEEE Aerospace Big Sky, Montana, March 2−9, 2019 p1

[26] Yilmaz A, Javed O, Shah M 2006 ACM Comput. Surv. 38 13

Google Scholar

Google Scholar

[27] Breitenstein M D, Reichlin F, Leibe B, Koller-Meier E, Van Gool L 2010 IEEE Trans. Pattern Anal. Mach. Intell. 33 1820

[28] Gordon N J, Salmond D J, Smith A F 1993 IEE Proc. F. 140 107

[29] Breitenstein M D, Reichlin F, Leibe B, Koller-Meier E, Van Gool L 2009 IEEE International Conference on Computer Vision Kyoto, Japan, September 29−October 2, 2009 p1515

[30] Xu R, Guan Y, Huang Y 2015 Multimed. Tools. Appl. 74 729

Google Scholar

Google Scholar

[31] Xiang Y, Alahi A, Savarese S 2015 IEEE International Conference on Computer Vision Santiago, Chile, December 13−16, 2015 p4705

[32] White C 2001 Markov Decision Processes (New York: Springer) pp32−40

[33] Bolme D S, Beveridge J R, Draper B A, Lui Y M 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition San Francisco, CA, June 13−18, 2019 p2544

[34] Henriques J F, Caseiro R, Martins P, Batista J 2015 IEEE Trans. Pattern Anal. Mach. Intell. 37 583

Google Scholar

Google Scholar

[35] Henriques J F, Caseiro R, Martins P, Batista J 2012 European Conference on Computer Vision Firenze, Italy, October 7−13, 2012 p702

[36] 王松 2017 硕士学位论文 (杭州: 浙江大学)

Wang S 2017 M.S. Thesis (Hangzhou: Zhejiang University) (in Chinese)

[37] 邓雪菲, 彭先容, 张建林, 徐智勇 2019 光电技术及应用 40 742

Deng X F, Peng X Y, Zhang J L, Xu Z Y 2019 Semiconduct. Optoelectron. 40 742

[38] 周飞燕, 金林鹏, 董军 2019 计算机学报 40 1229

Zhou F Y, Jin L P, Dong J 2019 Chin. J. Comput. 40 1229

[39] Marcus G 2018 arXiv: 1801.00631[cs]

[40] Goodfellow I, Bengio Y, Courville A 2016 Deep Learning (London: MIT press) pp10−15

[41] Luo W, Xing J, Milan A, Zhang X, Liu W, Zhao X, Kim T K 2014 arXiv: 1409.7618 [cs]

[42] LeCun Y 1989 Connectionism in Perspective (North Holland: Citeseer) pp23−25

[43] Krizhevsky A, Sutskever I, Hinton G E 2012 Advances in Neural Information Processing Systems Lake Tahoe, Nevada, December 3−6, 2012 p1097

[44] LeCun Y, Bottou L, Bengio Y, Haffner P 1998 Proceedings of the IEEE Leuven, Belgium, May 20−20, 1998 p2278

[45] Girshick R, Donahue J, Darrell T, Malik J 2014 IEEE Conference on Computer Vision and Pattern Recognition Columbus, Ohio, June 24−27, 2014 p580

[46] Uijlings J R, Van De Sande K E, Gevers T, Smeulders A W 2013 Int. J. Comput. Vis. 104 154

Google Scholar

Google Scholar

[47] Ren S, He K, Girshick R, Sun J 2015 IEEE Trans. Pattern Anal. Mach. Intell. 39 1137

[48] He K, Zhang X, Ren S, Sun J 2014 IEEE Trans. Pattern Anal. Mach. Intell. 37 1904

[49] Li Y, Hu J, Ji B 2019 Journal of Physics: Conference Series p022119

[50] 陈怡佳 2019 硕士学位论文 (哈尔滨: 哈尔滨理工大学)

Chen Y J 2019 M.S. Thesis (Harbin: Harbin University of Science and Technology) (in Chinese)

[51] 聂文昌 2019 硕士学位论文 (哈尔滨: 哈尔滨工程大学)

Nie W C 2019 M.S. Thesis (Harbin: Harbin Engineering University) (in Chinese)

[52] Redmon J, Divvala S, Girshick R, Farhadi A 2016 IEEE Conference on Computer Vision and Pattern Recognition Las Vegas, Nevada, June 26−July 1, 2016 p779

[53] Mittal N, Akarsh V, Kapoor S 2019 Int. J. Sci. Res. Eng. Trends 5 562

[54] Szegedy C, Liu W, Jia Y, Sermanet P, Reed S, Anguelov D, Erhan D, Vanhoucke V, Rabinovich A 2015 IEEE Conference on Computer Vision and Pattern Recognition Boston, Massachusetts, June 8−10, 2015 p1

[55] 杨眷玉 2016 硕士学位论文 (成都: 电子科技大学)

Yang J Y 2019 M.S. Thesis (Chengdu: University of Electronic Science and Technology of China) (in Chinese)

[56] Redmon J, Farhadi A 2017 IEEE Conference on Computer Vision and Pattern Recognition Honolulu, HI, July 21−26, 2017 p7263

[57] Redmon J, Farhadi A 2018 arXiv: 1804.02767[cs]

[58] Lin T Y, Goyal P, Girshick R, He K, Dollár P 2017 IEEE International Conference on Computer Vision Venice, Italy, October 22−29, 2017 p2980

[59] Law H, Deng J 2018 European Conference on Computer Vision Munich, Germany, September 8−14, 2018 p734

[60] Zhou X, Wang D, Krähenbühl P 2019 arXiv: 1904.07850[cs]

[61] Duan K, Bai S, Xie L, Qi H, Huang Q, Tian Q 2019 IEEE International Conference on Computer Vision Seoul, Korea, October 27−November 2, 2019 p6569

[62] Bernardin K, Stiefelhagen R 2008 Eurasip J. Image Vide. 2008 246309

[63] Leal-Taixé L, Milan A, Reid I, Roth S, Schindler K 2015 arXiv: 1504.01942[cs]

[64] Shantaiya S, Verma K, Mehta K 2015 Eur. J. Adv. Eng. Tech. 2 34

[65] Yang Y, Bilodeau G A 2017 Proceedings of the Computer and Robot Vision Edmonton, Canada, May 16−19, 2017 p209

[66] Chen L, Ai H, Shang C, Zhuang Z, Bai B 2017 IEEE International Conference on Image Beijing, China, September 17−20, 2017 p645

[67] Yi Z, Shen Y, Zhao Q 2019 Optik 194 163124

Google Scholar

Google Scholar

[68] 周涛, 韩筱璞, 闫小勇, 杨紫陌, 赵志丹, 汪秉宏 2013 电子科技大学学报 42 481

Google Scholar

Google Scholar

Zhou T, Han P X, Yan Y X, Yang Z M, Zhao Z D, Wang B H 2013 J. Univ. Electron. Sci. Technol. China 42 481

Google Scholar

Google Scholar

[69] Barbosa H, Barthelemy M, Ghoshal G, James C R, Lenormand M, Louail T, Menezes R, Ramasco J J, Simini F, Tomasini M 2018 Phys. Rep. 734 1

Google Scholar

Google Scholar

[70] Yan X Y, Wang W X, Gao Z Y, Lai Y C 2017 Nat. Commun. 8 1639

Google Scholar

Google Scholar

[71] Henderson L F 1974 Transp. Res. 8 509

Google Scholar

Google Scholar

[72] Henderson L 1971 Nature 229 381

Google Scholar

Google Scholar

[73] Henderson L, Lyons D 1972 Nature 240 353

Google Scholar

Google Scholar

[74] Henderson L, Jenkins D 1974 Transp. Res. 8 71

Google Scholar

Google Scholar

[75] Helbing D 1998 Complex Syst. 6 391

[76] Alberti E, Belli G 1978 Transp. Res. 12 33

Google Scholar

Google Scholar

[77] Helbing D 1991 Behav. Sci. 36 298

Google Scholar

Google Scholar

[78] Keizer J 2012 Statistical Thermodynamics of Nonequilibrium Processes (New York: Springer) pp22−34

[79] Helbing D 1992 Physica A 181 29

Google Scholar

Google Scholar

[80] Haase K, Kasper M, Koch M, Müller S 2019 Oper. Res. 67 376

[81] Dong H, Zhou M, Wang Q, Yang X, Wang F Y 2019 IEEE Trans. Intell. Transp. Syst. DOI: 10.1109/TITS.2019.2915014

[82] Johansson A, Helbing D, Shukla P K 2007 Adv. Complex Syst. 10 271

[83] Frank G A, Dorso C O 2011 Physica A 390 2135

Google Scholar

Google Scholar

[84] Moussaïd M, Helbing D, Theraulaz G 2011 Proc. Natl. Acad. Sci. U.S.A. 108 6884

Google Scholar

Google Scholar

[85] Gibson J J 1958 Br. J. Psychol. 49 182

Google Scholar

Google Scholar

[86] Batty M 1997 Nature 388 19

Google Scholar

Google Scholar

[87] Turner A, Penn A 2002 Environ. Plann. B Plann. Des. 29 473

[88] Porter E, Hamdar S H, Daamen W 2018 Transp. 14 361

[89] Collins R T, Lipton A J, Kanade T 2000 IEEE Trans. Pattern Anal. Mach. Intell. 22 745

Google Scholar

Google Scholar

[90] Ferrando S, Gera G, Regazzoni C 2006 IEEE International Conference on Video and Signal Based Surveillance Sydney, Australia, November 22−24, 2006 p21

[91] 刘晓冬, 苏光大, 周全, 田超 2019 中国图像图形学报 5 1024

Liu X D, Su G D, Zhou Q, Tian C 2019 J. Image Graph. 5 1024

[92] 万琴, 王耀南 2007 计算机应用研究 1 199

Google Scholar

Google Scholar

Wang Q, Wang N Y 2007 Appl. Res. Comput. 1 199

Google Scholar

Google Scholar

[93] Nikouei S Y, Chen Y, Faughnan T R 2018 Proceedings of the IEEE/ACM Symposium on Edge Computing Bellevue, WA, October 25−27, 2018 p336

[94] Gajjar V, Gurnani A, Khandhediya Y 2017 IEEE International Conference on Computer Vision Venice, Italy, October 22−29, 2017 p2805

[95] Helbing D, Frankas I, Vicsek T 2000 Nature 407 487

Google Scholar

Google Scholar

[96] Helbing D 2013 Nature 497 51

Google Scholar

Google Scholar

[97] Haghani M, Sarvi M 2017 Transp. Res. B Meth. 107 253

[98] Zawbaa H M, Aly S A, Gutub A A 2012 arXiv: 1209.3433[cs]

[99] Helbing D, Johansson A, Zein H, Abideen A 2007 Phys. Rev. E 75 046109

Google Scholar

Google Scholar

[100] Zhao Y, Li M, Xin L, Tian L, Yu Z, Kai H, Wang Y, Li T 2017 Physica A 465 175

Google Scholar

Google Scholar

[101] 汪秉宏, 周涛, 史冬梅 2016 现代物理知识 28 50

Wang B H, Zhou T, Shi D M 2016 Mod. Phys. 28 50

[102] Yogameena B, Nagananthini C 2017 Int. J. Disast. Risk. Re. 22 95

[103] Miaou S G, Sung P H, Huang C Y 2006 Proceedings of the Distributed Diagnosis and Home Healthcare Arlington, VA, April 2−4, 2006 p39

[104] Zhu J, Javed O, Liu J, Qian Y, Sawhney H 2014 IEEE Conference on Computer Vision and Pattern Recognition Columbus, Ohio, Jun 24−27, 2014 p3510

[105] Kocabas M, Karagoz S, Akbas E 2018 European Conference on Computer Vision Munich, Germany, September 8−14, 2018 p417

[106] Lu X, Wrathall D J, Sundsøy P R, Nadiruzzaman M, Wetter E, Iqbal A, Qureshi T, Tatem A J, Canright G S, Engø-Monsen K 2016 Clim. Change 138 505

Google Scholar

Google Scholar

[107] Lu X, Wrathall D J, Sundsøy P R, Nadiruzzaman M, Wetter E, Iqbal A, Qureshi T, Tatem A, Canright G, Engø-Monsen K 2016 Glob. Environ. Change 38 1

Google Scholar

Google Scholar

[108] Lu X, Bengtsson L, Holme P 2012 Proc. Natl. Acad. Sci. U.S.A. 109 11576

Google Scholar

Google Scholar

[109] Lu X, Wetter E, Bharti N, Tatem A J, Bengtsson L 2013 Sci. Rep. 3 2923

Google Scholar

Google Scholar

[110] Gonzalez M C, Hidalgo C A, Barabasi A L 2008 Nature 453 779

Google Scholar

Google Scholar

[111] Lu X, Brelsford C 2014 Sci. Rep. 4 6773

[112] Huang G, Cai M, Lu X 2019 Inter. J. Environ. Res. Pub. Heal. 16 3597

Google Scholar

Google Scholar

[113] 吕欣 2018 中国计算机学会通讯 14 56

Lu X 2018 Commun. CCF 14 56

计量

- 文章访问数: 33967

- PDF下载量: 703

- 被引次数: 0

下载:

下载: