-

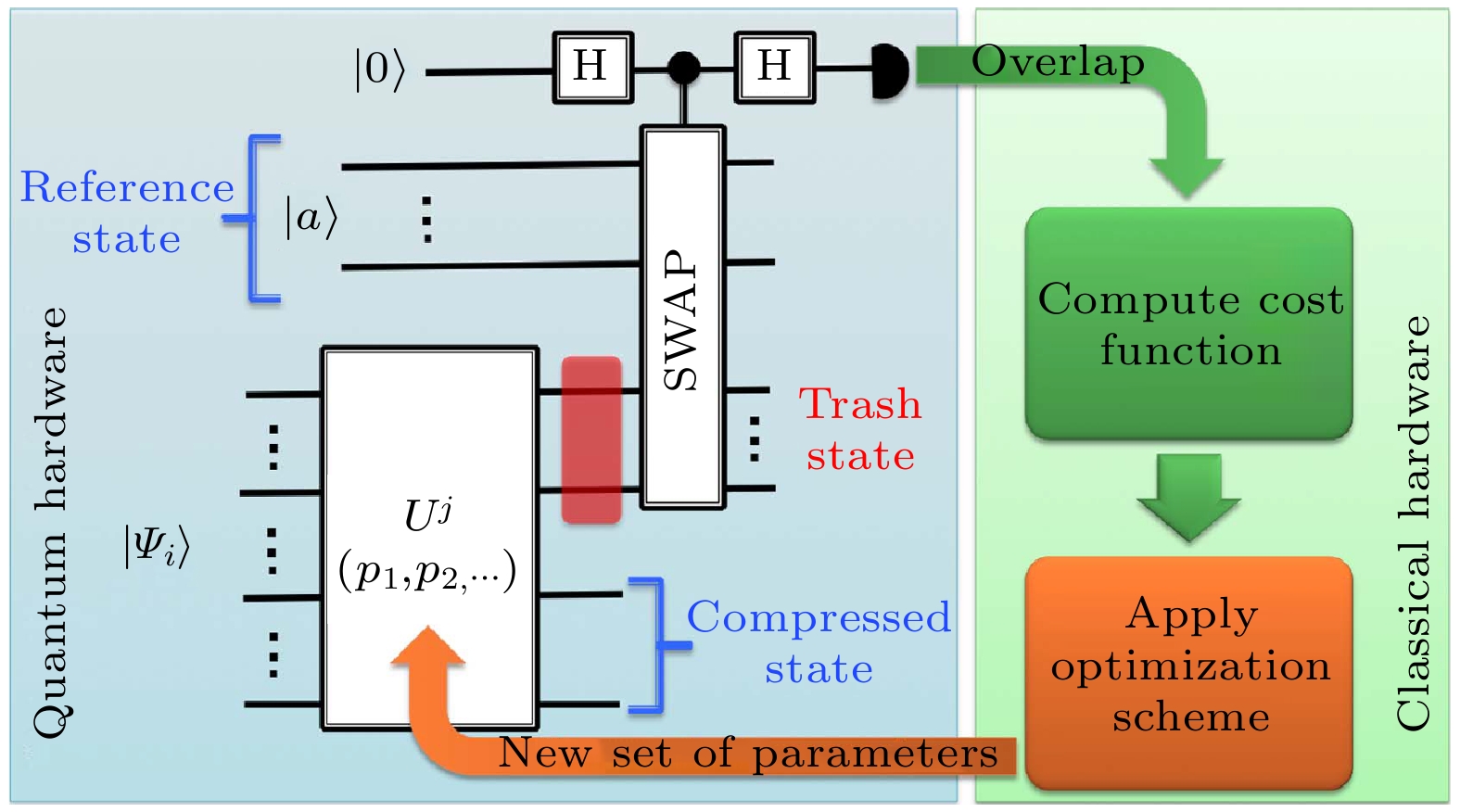

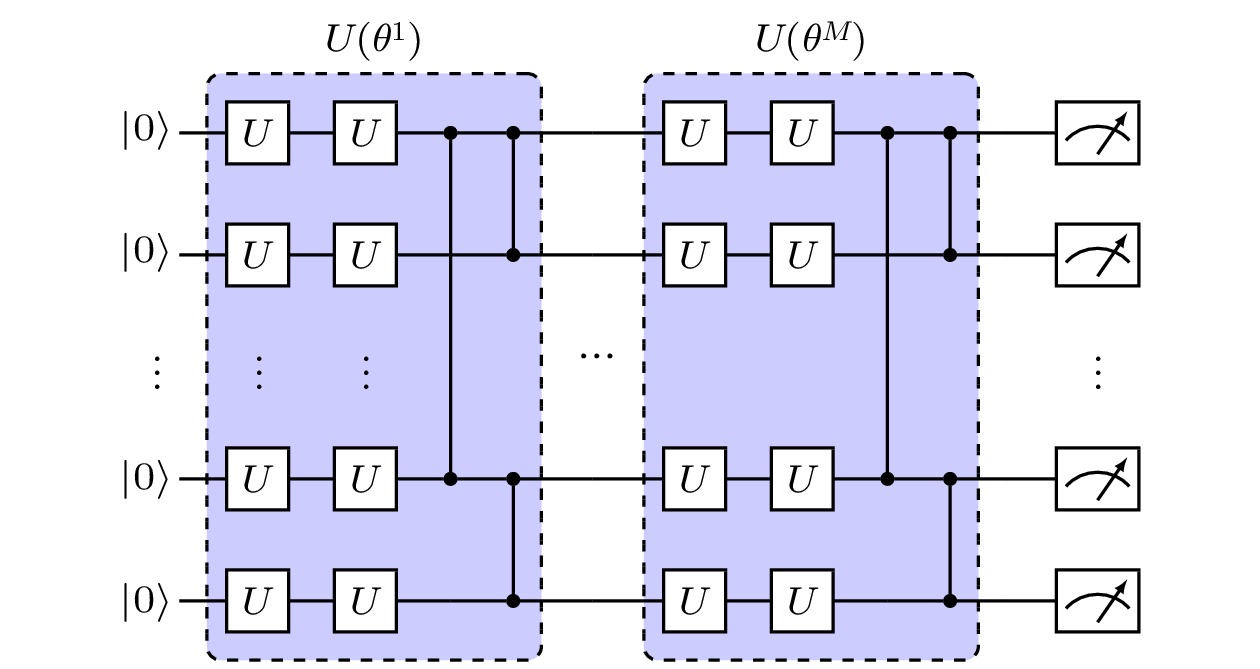

近年来, 很多基于生成模型的机器学习算法, 如生成对抗网络、玻尔兹曼机、自编码器等, 在数据生成、概率模拟等方面有广泛的应用. 另一方面, 融合量子计算和经典机器学习的量子机器学习算法也不断被提出. 特别地, 量子生成模型作为量子机器学习的分支, 目前已有很多进展. 量子生成算法是一类量子-经典混合算法, 算法中引入参数量子线路, 通过执行参数线路得到损失函数及其梯度, 然后通过经典的优化算法来优化求解, 从而完成对应的生成任务. 与经典生成模型相比, 量子生成模型通过参数线路将数据流映射到高维希尔伯特空间, 在高维空间中学习数据的特征, 从而在一些特定问题上超越经典生成模型. 在中等规模含噪声的量子体系下, 量子生成模型是一类有潜力实现量子优势的量子机器学习算法.In recent years, many generation-based machine learning algorithms such as generative adversarial networks, Boltzmann machine, auto-encoder, etc. are widely used in data generation and probability distribution simulation. On the other hand, the combined algorithms of quantum computation and classical machine learning algorithms are proposed in various styles. Especially, there exist many relevant researches about quantum generative models, which are regarded as the branch of quantum machine learning. Quantum generative models are hybrid quantum-classical algorithms, in which parameterized quantum circuits are introduced to obtain the cost function of the task as well as its gradient, and then classical optimization algorithms are used to find the optima. Compared with its classical counterpart, quantum generative models map the data stream to high-dimensional Hilbert space with parameterized quantum circuits. In the mapping space, data features are easier to learn, which can surpass classical generative models in some tasks. Besides, quantum generative models are potential to realize the quantum advantage in noisy intermediate-scale quantum devices.

[1] Zhu J Y, Krähenbühl P, Shechtman E, Efros A A 2016 European Conference on Computer Vision, Berlin, September 16, 2016 p597

[2] Oord A, Dieleman S, Zen H, Simonyan K, Vinyals O, Graves A, Kalchbrenner N, Senior A, Kavukcuoglu K 2016 arXiv: 1609.03499 [cs.SD]

[3] Gómez-Bombarelli R, Wei J N, Duvenaud D, Hernández-Lobato J M, Sánchez-Lengeling B, Sheberla D, Aguilera-Iparraguirre J, Hirzel T D, Adams R P, Aspuru-Guzik A 2018 ACS Cent. Sci. 4 268

Google Scholar

Google Scholar

[4] Isola P, Zhu J Y, Zhou T, Efros A A 2016 arXiv: 1611.07004[cs.CV]

[5] Dallaire-Demers P L, Killoran N 2018 Phys. Rev. A 98 012324

Google Scholar

Google Scholar

[6] Lloyd S, Weedbrook C 2018 Phys. Rev. Lett. 121 040502

Google Scholar

Google Scholar

[7] Benedetti M, Garcia-Pintos D, Perdomo O, Leyton-Ortega V, Nam Y, Perdomo-Ortiz A 2019 npj Quantum Inf. 5 1

[8] Liu J G, Wang L 2018 Phys. Rev. A 98 062324

Google Scholar

Google Scholar

[9] Amin M H, Andriyash E, Rolfe J, Kulchytskyy B, Melko R 2018 Phys. Rev. X 8 021050

[10] Khoshaman A, Vinci W, Denis B, Andriyash E, Amin M H 2019 Quantum Sci. Technol. 4 014001

[11] Benedetti M, Realpe-Gómez J, Biswas R, PerdomoOrtiz A 2017 Phys. Rev. X 7 041052

[12] Kieferová M, Wiebe N 2017 Phys. Rev. A 96 062327

Google Scholar

Google Scholar

[13] Romero J, Olson J P, Aspuru-Guzik A 2017 Quantum Sci. Technol. 2 045001

Google Scholar

Google Scholar

[14] Lamata L, Alvarez-Rodriguez U, Martn-Guerrero J, Sanz M, Solano E 2018 Quantum Sci. Technol. 4 014007

Google Scholar

Google Scholar

[15] Li R, Alvarez-Rodriguez U, Lamata L, Solano E 2017 Quantum Meas. Quantum Metrol. 4 1

[16] Du Y, Liu T, Tao D 2018 arXiv: 1805.11089 [quant-ph]

[17] Peruzzo A, McClean J, Shadbolt P, Yung M H, Zhou Z Q, Love P J, Aspuru-Guzik A, O'Brien J L 2014 Nat. Commun. 5 4213

Google Scholar

Google Scholar

[18] Nielsen M A, Chuang I L 2002 Quantum computation and quantum information (Cambridge: Cambridge University Press) pp221–225

[19] Preskill J 2018 Quantum 2 79

Google Scholar

Google Scholar

[20] Harrow A W, Hassidim A, Lloyd S 2009 Phys. Rev. Lett. 103 150502

Google Scholar

Google Scholar

[21] Huang H L, Du Y, Gong M, Zhao Y, Wu Y, Wang C, Li S, Liang F, Lin J, Xu Y, Yang R, Liu T, Hsieh M H, Deng H, Rong H, Peng C Z, Lu C Y, Chen Y A, Tao D, Zhu X, Pan J W 2020 arXiv: 2010.06201 [quant-ph]

[22] Du Y, Hsieh M-H, Liu T, Tao D 2020 Phys. Rev. Research 2 033125

Google Scholar

Google Scholar

[23] Goodfellow I, Pouget-Abadie J, Mirza M, Xu B, WardeFarley D, Ozair S, Courville A, Bengio Y 2014 Proceedings of the 27th International Conference on Neural Information Processing Systems 2 pp2672–2680

[24] Gulrajani I, Ahmed F, Arjovsky M, Dumoulin V, Courville A C 2017 arXiv: 1704.00028 [cs.LG]

[25] Zoufal C, Lucchi A, Woerner S 2019 npj Quantum Inf. 5 103

Google Scholar

Google Scholar

[26] Zeng J, Wu Y, Liu J G, Wang L, Hu J 2019 Phys. Rev. A 99 052306

Google Scholar

Google Scholar

[27] Schuld M, Bergholm V, Gogolin C, Izaac J, Killoran N 2019 Phys. Rev. A 99 032331

Google Scholar

Google Scholar

[28] MacKay D J C 2002 Information Theory, Inference & Learning Algorithms (Cambridge: Cambridge University)

[29] Situ H, He Z, Wang Y, Li L, Zheng S 2020 Information Sciences 538 193

Google Scholar

Google Scholar

[30] Hu L, Wu S H, Cai W, Ma Y, Mu X, Xu Y, Wang H, Song Y, Deng D L, Zou C L, Sun L 2019 Sci. Adv. 5 eaav2761

Google Scholar

Google Scholar

[31] Rudolph M S, Toussaint N B, Katabarwa A, Johri S, Peropadre B, Perdomo-Ortiz A 2020 arXiv: 2012.03924 v2 [quant-ph]

[32] Cheng S, Chen J, Wang L 2018 Entropy 20 583

Google Scholar

Google Scholar

[33] Hinton G E, Sejnowski T J 1986 In Parallel Distributed Processing: Explorations in the Microstructure of Cognition 1 282

[34] Hinton G E 2012 In Neural Networks: Tricks of the Trade Berlin Heidelberg, Germany, 2012 p599

[35] Coyle B, Mills D, Danos V, Kashefi E 2020 npj Quantum Inf. 6 60

Google Scholar

Google Scholar

[36] Hofmann T, Schölkopf B, Smola A J 2008 Ann. Statist. 36 1171

[37] Hinton G E, Sejnowski T J 1983 Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Washington D. C., USA, 1983 p448

[38] Hinton G E, Osindero S, Teh Y-W 2006 Neural Comput. 18 1527

Google Scholar

Google Scholar

[39] Salakhutdinov R, Hinton G 2009 Proceedings of the Twelth International Conference on Artificial Intelligence and Statistics Florida, USA 2009 p448

[40] Smolensky P 1986 Parallel Distributed Processing: Explorations in the Microstructure of Cognition (Vol.1) (Cambridge: MIT press) pp194–281

[41] Dorband J E 2015 12th International Conference on Information Technology-New Generations Las Vegas, USA, April 13–15, 2015 p703

[42] Buhrman H, Cleve R, Watrous J, Wolf R D 2001 Phys. Rev. Lett. 87 167902

Google Scholar

Google Scholar

[43] Ding Y, Lamata L, Sanz M, Chen X, Solano E 2019 Adv. Quantum Technol. 2 1800065

Google Scholar

Google Scholar

[44] Pepper A, Tischler N, Pryde G J 2019 Phys. Rev. Lett. 122 060501

Google Scholar

Google Scholar

[45] Bondarenko D, Feldmann P 2020 Phys. Rev. Lett. 124 130502

Google Scholar

Google Scholar

[46] Huang C J, Ma H, Yin Q, Tang J F, Dong D, Chen C, Xiang G Y, Li C F, Guo G C 2020 Phys. Rev. A 102 032412

Google Scholar

Google Scholar

[47] Cao C, Wang X 2021 Phys. Rev. Applied. 15 054012

Google Scholar

Google Scholar

[48] Cerezo M, Sone A, Volkoff T, Patrick L C, Coles J 2021 Nat. Commun. 12 1791

Google Scholar

Google Scholar

[49] Gao X, Zhang Z Y, Duan L-M 2018 Sci. Adv. 4 eaat9004

Google Scholar

Google Scholar

[50] Gao X, Anschuetz E R, Wang S T, Cirac J I, Lukin M D 2021 arXiv: 2101.08354 v1 [quant-ph]

-

-

[1] Zhu J Y, Krähenbühl P, Shechtman E, Efros A A 2016 European Conference on Computer Vision, Berlin, September 16, 2016 p597

[2] Oord A, Dieleman S, Zen H, Simonyan K, Vinyals O, Graves A, Kalchbrenner N, Senior A, Kavukcuoglu K 2016 arXiv: 1609.03499 [cs.SD]

[3] Gómez-Bombarelli R, Wei J N, Duvenaud D, Hernández-Lobato J M, Sánchez-Lengeling B, Sheberla D, Aguilera-Iparraguirre J, Hirzel T D, Adams R P, Aspuru-Guzik A 2018 ACS Cent. Sci. 4 268

Google Scholar

Google Scholar

[4] Isola P, Zhu J Y, Zhou T, Efros A A 2016 arXiv: 1611.07004[cs.CV]

[5] Dallaire-Demers P L, Killoran N 2018 Phys. Rev. A 98 012324

Google Scholar

Google Scholar

[6] Lloyd S, Weedbrook C 2018 Phys. Rev. Lett. 121 040502

Google Scholar

Google Scholar

[7] Benedetti M, Garcia-Pintos D, Perdomo O, Leyton-Ortega V, Nam Y, Perdomo-Ortiz A 2019 npj Quantum Inf. 5 1

[8] Liu J G, Wang L 2018 Phys. Rev. A 98 062324

Google Scholar

Google Scholar

[9] Amin M H, Andriyash E, Rolfe J, Kulchytskyy B, Melko R 2018 Phys. Rev. X 8 021050

[10] Khoshaman A, Vinci W, Denis B, Andriyash E, Amin M H 2019 Quantum Sci. Technol. 4 014001

[11] Benedetti M, Realpe-Gómez J, Biswas R, PerdomoOrtiz A 2017 Phys. Rev. X 7 041052

[12] Kieferová M, Wiebe N 2017 Phys. Rev. A 96 062327

Google Scholar

Google Scholar

[13] Romero J, Olson J P, Aspuru-Guzik A 2017 Quantum Sci. Technol. 2 045001

Google Scholar

Google Scholar

[14] Lamata L, Alvarez-Rodriguez U, Martn-Guerrero J, Sanz M, Solano E 2018 Quantum Sci. Technol. 4 014007

Google Scholar

Google Scholar

[15] Li R, Alvarez-Rodriguez U, Lamata L, Solano E 2017 Quantum Meas. Quantum Metrol. 4 1

[16] Du Y, Liu T, Tao D 2018 arXiv: 1805.11089 [quant-ph]

[17] Peruzzo A, McClean J, Shadbolt P, Yung M H, Zhou Z Q, Love P J, Aspuru-Guzik A, O'Brien J L 2014 Nat. Commun. 5 4213

Google Scholar

Google Scholar

[18] Nielsen M A, Chuang I L 2002 Quantum computation and quantum information (Cambridge: Cambridge University Press) pp221–225

[19] Preskill J 2018 Quantum 2 79

Google Scholar

Google Scholar

[20] Harrow A W, Hassidim A, Lloyd S 2009 Phys. Rev. Lett. 103 150502

Google Scholar

Google Scholar

[21] Huang H L, Du Y, Gong M, Zhao Y, Wu Y, Wang C, Li S, Liang F, Lin J, Xu Y, Yang R, Liu T, Hsieh M H, Deng H, Rong H, Peng C Z, Lu C Y, Chen Y A, Tao D, Zhu X, Pan J W 2020 arXiv: 2010.06201 [quant-ph]

[22] Du Y, Hsieh M-H, Liu T, Tao D 2020 Phys. Rev. Research 2 033125

Google Scholar

Google Scholar

[23] Goodfellow I, Pouget-Abadie J, Mirza M, Xu B, WardeFarley D, Ozair S, Courville A, Bengio Y 2014 Proceedings of the 27th International Conference on Neural Information Processing Systems 2 pp2672–2680

[24] Gulrajani I, Ahmed F, Arjovsky M, Dumoulin V, Courville A C 2017 arXiv: 1704.00028 [cs.LG]

[25] Zoufal C, Lucchi A, Woerner S 2019 npj Quantum Inf. 5 103

Google Scholar

Google Scholar

[26] Zeng J, Wu Y, Liu J G, Wang L, Hu J 2019 Phys. Rev. A 99 052306

Google Scholar

Google Scholar

[27] Schuld M, Bergholm V, Gogolin C, Izaac J, Killoran N 2019 Phys. Rev. A 99 032331

Google Scholar

Google Scholar

[28] MacKay D J C 2002 Information Theory, Inference & Learning Algorithms (Cambridge: Cambridge University)

[29] Situ H, He Z, Wang Y, Li L, Zheng S 2020 Information Sciences 538 193

Google Scholar

Google Scholar

[30] Hu L, Wu S H, Cai W, Ma Y, Mu X, Xu Y, Wang H, Song Y, Deng D L, Zou C L, Sun L 2019 Sci. Adv. 5 eaav2761

Google Scholar

Google Scholar

[31] Rudolph M S, Toussaint N B, Katabarwa A, Johri S, Peropadre B, Perdomo-Ortiz A 2020 arXiv: 2012.03924 v2 [quant-ph]

[32] Cheng S, Chen J, Wang L 2018 Entropy 20 583

Google Scholar

Google Scholar

[33] Hinton G E, Sejnowski T J 1986 In Parallel Distributed Processing: Explorations in the Microstructure of Cognition 1 282

[34] Hinton G E 2012 In Neural Networks: Tricks of the Trade Berlin Heidelberg, Germany, 2012 p599

[35] Coyle B, Mills D, Danos V, Kashefi E 2020 npj Quantum Inf. 6 60

Google Scholar

Google Scholar

[36] Hofmann T, Schölkopf B, Smola A J 2008 Ann. Statist. 36 1171

[37] Hinton G E, Sejnowski T J 1983 Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Washington D. C., USA, 1983 p448

[38] Hinton G E, Osindero S, Teh Y-W 2006 Neural Comput. 18 1527

Google Scholar

Google Scholar

[39] Salakhutdinov R, Hinton G 2009 Proceedings of the Twelth International Conference on Artificial Intelligence and Statistics Florida, USA 2009 p448

[40] Smolensky P 1986 Parallel Distributed Processing: Explorations in the Microstructure of Cognition (Vol.1) (Cambridge: MIT press) pp194–281

[41] Dorband J E 2015 12th International Conference on Information Technology-New Generations Las Vegas, USA, April 13–15, 2015 p703

[42] Buhrman H, Cleve R, Watrous J, Wolf R D 2001 Phys. Rev. Lett. 87 167902

Google Scholar

Google Scholar

[43] Ding Y, Lamata L, Sanz M, Chen X, Solano E 2019 Adv. Quantum Technol. 2 1800065

Google Scholar

Google Scholar

[44] Pepper A, Tischler N, Pryde G J 2019 Phys. Rev. Lett. 122 060501

Google Scholar

Google Scholar

[45] Bondarenko D, Feldmann P 2020 Phys. Rev. Lett. 124 130502

Google Scholar

Google Scholar

[46] Huang C J, Ma H, Yin Q, Tang J F, Dong D, Chen C, Xiang G Y, Li C F, Guo G C 2020 Phys. Rev. A 102 032412

Google Scholar

Google Scholar

[47] Cao C, Wang X 2021 Phys. Rev. Applied. 15 054012

Google Scholar

Google Scholar

[48] Cerezo M, Sone A, Volkoff T, Patrick L C, Coles J 2021 Nat. Commun. 12 1791

Google Scholar

Google Scholar

[49] Gao X, Zhang Z Y, Duan L-M 2018 Sci. Adv. 4 eaat9004

Google Scholar

Google Scholar

[50] Gao X, Anschuetz E R, Wang S T, Cirac J I, Lukin M D 2021 arXiv: 2101.08354 v1 [quant-ph]

计量

- 文章访问数: 11206

- PDF下载量: 414

- 被引次数: 0

下载:

下载: