-

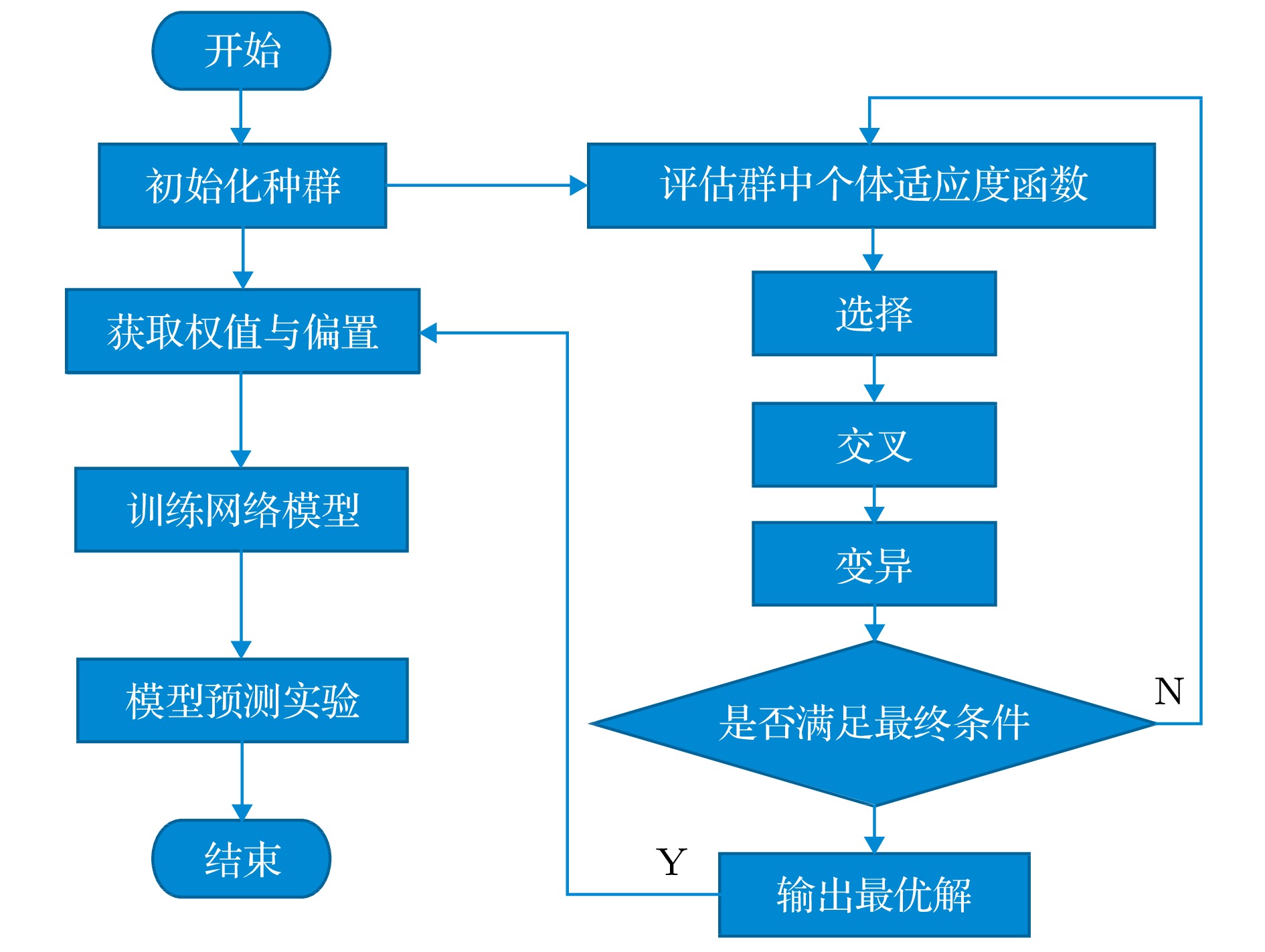

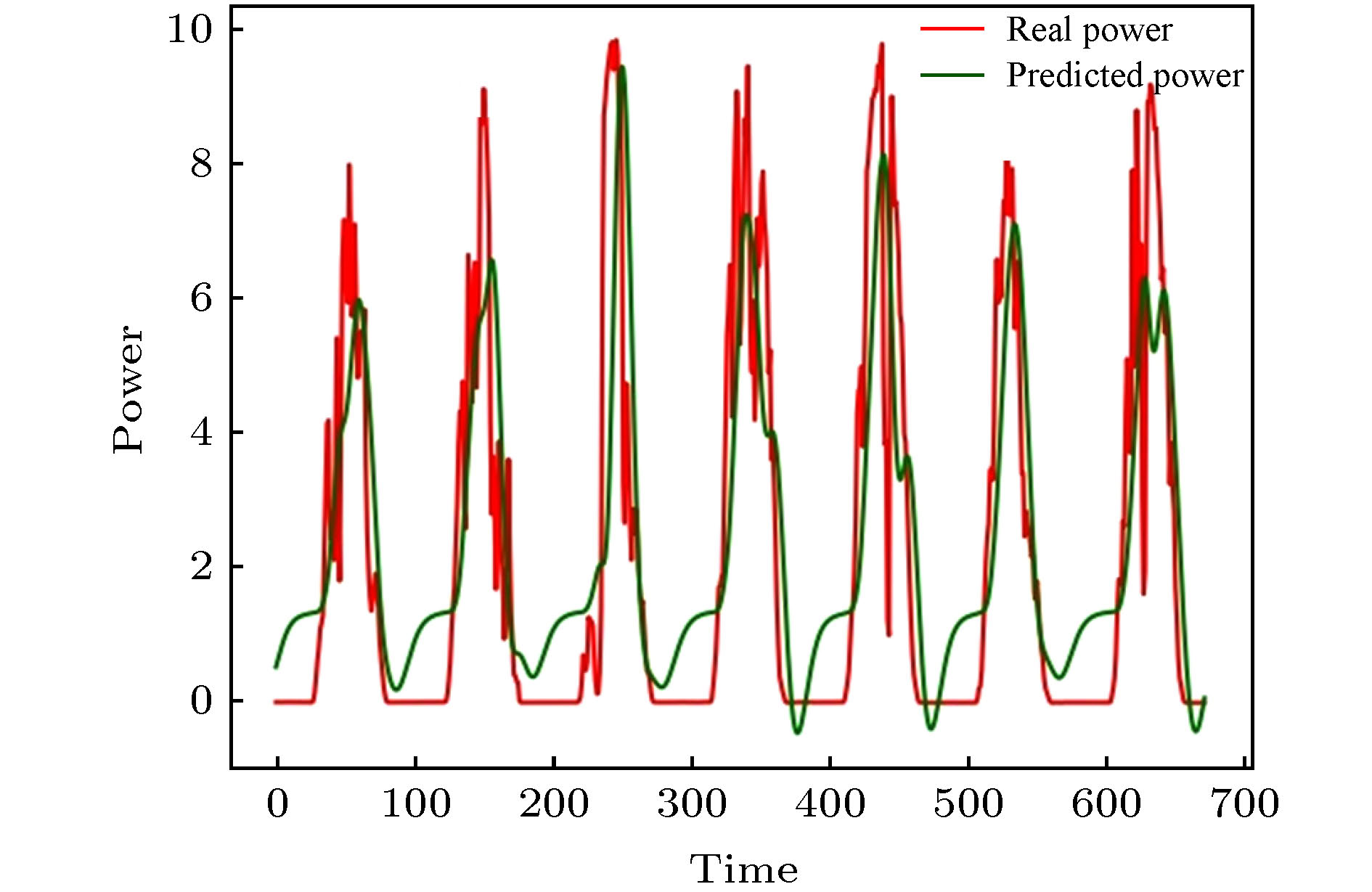

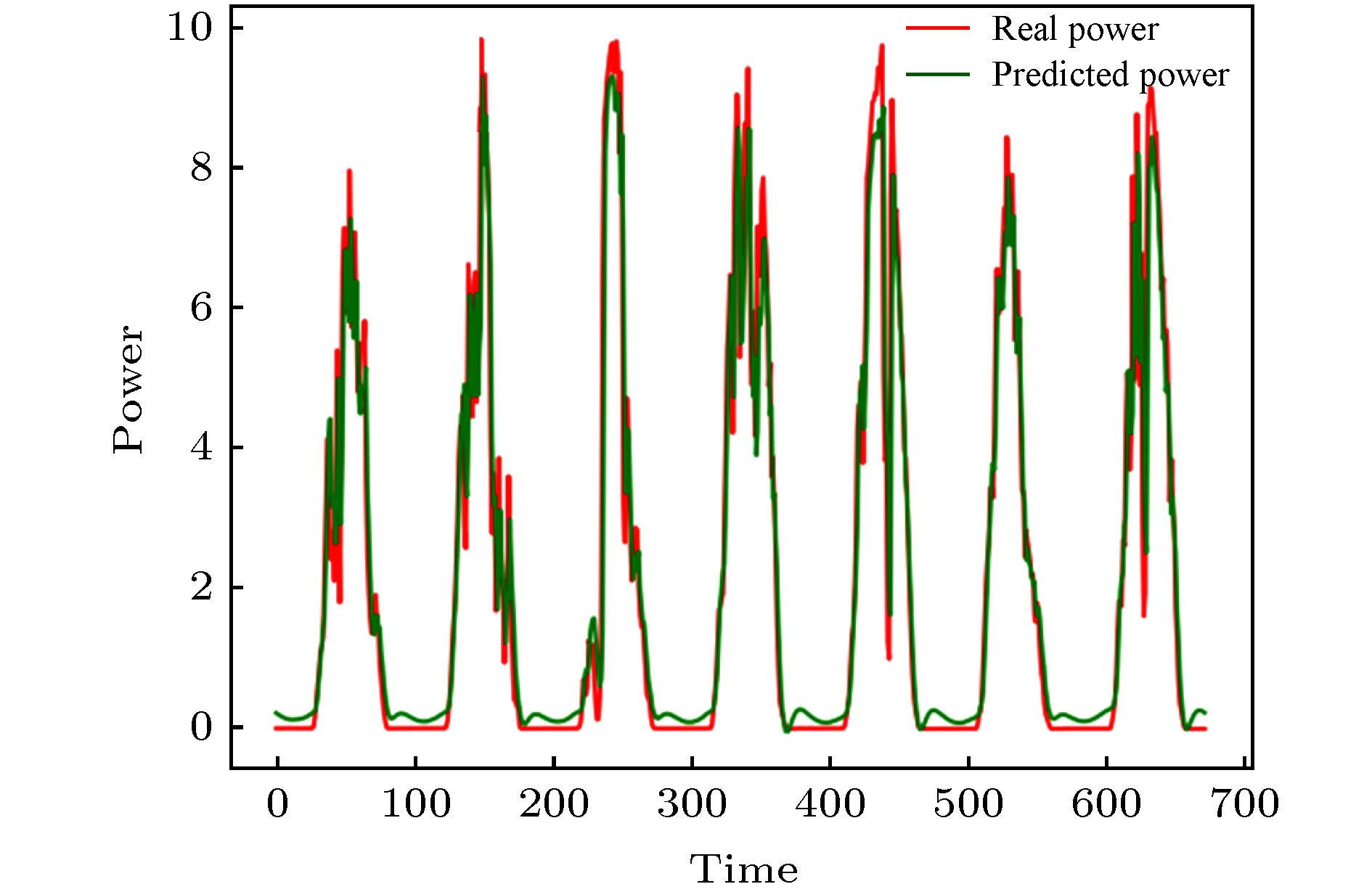

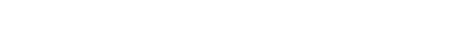

光伏发电受天气与地理环境影响, 呈现出波动性和随机多干扰性, 其输出功率容易随着外界因素变化而变化, 因此预测发电输出功率对于优化光伏发电并网运行和减少不确定性的影响至关重要. 本文提出一种基于遗传算法(GA)优化的卷积长短记忆神经网络混合模型(GA-CNN-LSTM), 首先利用CNN模块对数据的空间特征提取, 再经过LSTM模块提取时间特征和附近隐藏状态向量, 同时通过GA优化LSTM训练网络的超参数权重与偏置值. 在初期对历史数据进行归一化处理, 以及对所有特征作灰色关联度分析, 提取重要特征降低数据计算复杂度, 然后对本文提出来的经GA优化后的CNN-LSTM混合神经网络(GA-CNN-LSTM)算法模型进行光伏功率预测实验. 同时与CNN, LSTM两个单一神经网络模型以及未经GA优化的CNN-LSTM混合神经网络模型的预测性能进行比较. 结果显示在平均绝对误差率(MAPE)指标下, 本文提出的GA-CNN-LSTM算法模型比单一神经网络模型最好的结果减少了1.537%的误差, 同时比未经优化的CNN-LSTM混合神经网络算法模型减少了0.873%的误差. 本文的算法模型对光伏发电功率具有更好的预测性能.Photovoltaic power generation is affected by weather and geographical environment, showing fluctuations and random multi-interference, and its output power is easy to change with changes in external factors. Therefore, the prediction of output power is crucial to optimize the grid-connected operation of photovoltaic power generation and reduce the impact of uncertainty. This paper proposes a hybrid model of both convolutional neural network (CNN) and long short-term memory neural network (LSTM) based on genetic algorithm (GA) optimization (GA-CNN-LSTM). First, the CNN module is used to extract the spatial features of the data, and then the LSTM module is used to extract the temporal features and nearby hidden states. Optimizing the hyperparameter weights and bias values of the LSTM training network through GA. At the initial stage, the historical data is normalized, and all features were analyzed by grey relational degree. Important features are extracted to reduce the computational complexity of the data. Then, the GA-optimized CNN-LSTM hybrid neural network model (GA-CNN-LSTM) is applied for photovoltaic power prediction experiment. The GA-CNN-LSTM model was compared with the single neural network models such as CNN and LSTM, and the CNN-LSTM hybrid neural network model without GA optimization. Under the Mean Absolute Percentage Error index, the GA-CNN-LSTM algorithm proposed in this paper reduces the error by 1.537% compared with the ordinary single neural network model, and 0.873% compared with the unoptimized CNN-LSTM hybrid neural network algorithm model. From the perspective of training and test running time, the GA-CNN-LSTM model takes a little longer than the single neural network model, but the disadvantage is not obvious. To sum up, the performance of GA-CNN-LSTM model for photovoltaic power predicting is better.

-

Keywords:

- photovoltaic /

- artificial intelligence /

- convolutional neural network /

- long short-term memory neural network

[1] Wang K, Qi X, Liu H 2019 Appl. Energy 251 113315

Google Scholar

Google Scholar

[2] Kushwaha V, Pindoriya N M 2019 RenewableEnergy 140 124

Google Scholar

Google Scholar

[3] Shi J, Lee W J, Liu Y, Yang Y, Wang P 2012 IEEE Trans. Ind. Appl. 48 1064

Google Scholar

Google Scholar

[4] Liu Y, Zhao J, Zhang M, et al. 2016 The 12th International Conference on Natural Computation, Fuzzy Systems and Knowledge Discovery, Changsha, August, 2016 p29

[5] Liu L, Zhao Y, Chang D, Xie J, Ma Z, Sun Q, Wennersten R 2018 Appl. Energy 228 70

[6] Gao M, Li J, Hong F, Long D 2019 Energy 187 115

[7] Abdel-Nasser M, Mahmoud K 2019 Neural Comput. Appl. 31 2727

Google Scholar

Google Scholar

[8] 魏小辉 2019 硕士学位论文 (兰州: 兰州大学)

Wei X H 2019 M. S. Thesis (Lanzhou: Lanzhou University) (in Chinese)

[9] SrivastavaN, Hinton G, Krizhevsky A, et al. 2014 J. Mach. Learn Res. 15 1929

[10] https://www.pkbigdata.com/common/cmptIndex.html[2019-12-20]

[11] Ashburner J, Friston K J 1999 Hum. Brain Mapp. 7254

[12] Wei G W 2011 Expert Syst. Appl. 38 4824

Google Scholar

Google Scholar

[13] Wang K, Qi X, Liu H 2019 Energy 189 116225

Google Scholar

Google Scholar

[14] Chua L O 1997 Int. J. Bifurcation Chaos 7 2219

Google Scholar

Google Scholar

[15] SajjadM, Khan S, Hussain T, Muhammad K, Sangaiah A K, Castiglione A, Baik S W 2019 Pattern Recognit. Lett. 126 123

Google Scholar

Google Scholar

[16] Xiao F, Xiao Y, Cao Z, Gong K, Fang Z, Zhou J T 2019 Tenth International Conference on Graphics and Image Processing, Chengdu, China, 2018 p11069

[17] Hüsken M, Stagge P 2003 Neurocomputing 50 223

Google Scholar

Google Scholar

[18] Qing X, Niu Y 2018 Energy 148 461

Google Scholar

Google Scholar

[19] Ordóñez F, Roggen D 2016 Sensors 16 115

Google Scholar

Google Scholar

[20] Tan Z X, Goel A, Nguyen T S, Ong D C 2019 14th IEEE International Conference on Automatic Face & Gesture Recognition, Lille, France, May 14−18, 2019 p1

[21] Gensler A, Henze J, Sick B, et al. 2016 IEEE International Conference on Systems, Man, and Cybernetics, Budapest, Hungary, October 9−12, 2016 p002858

[22] Zhou X, Wan X, Xiao J 2016 Proceedings of the 2016 Conference on Empirical Methods in Natural Laguage Proccessing, Texas, USA, November 1−5, 2016 p247

[23] Goldberg D E, Samtani M P 1986 In Electronic Computation American Society of Civil Engineers, American, February 1986 p471

[24] Willmott C J, Matsuura K 2005 Clim. Res. 30 79

Google Scholar

Google Scholar

[25] Ip W C, Hu B Q, Wong H, Xia J 2009 J. Hydrol. 379 284

Google Scholar

Google Scholar

-

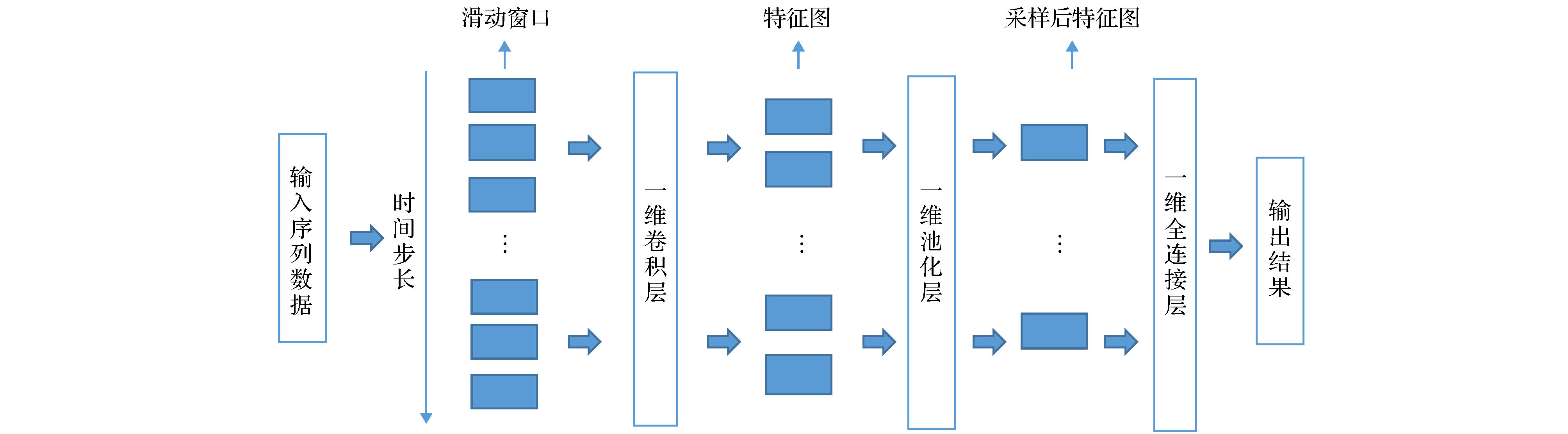

图 2 一维卷积神经网络结构[14]

Fig. 2. One dimensional convolutional neural network structure.

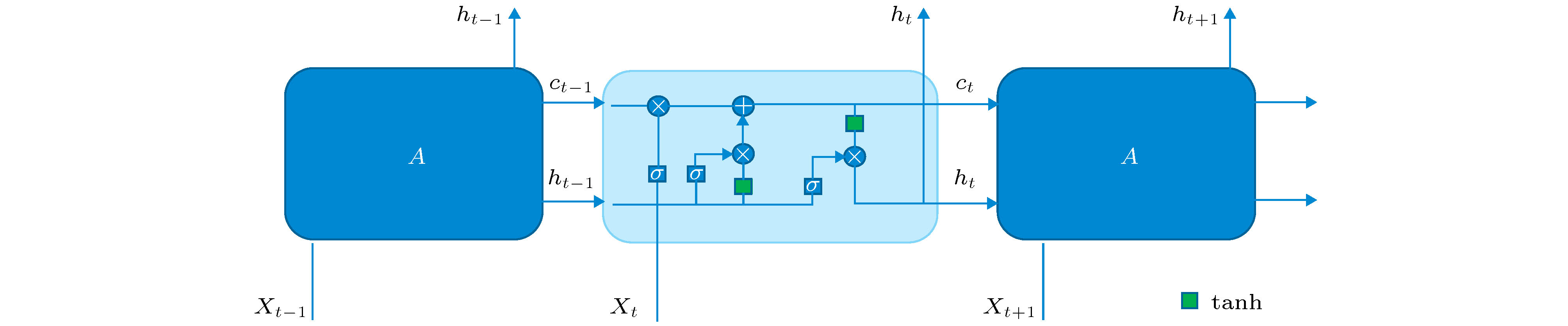

图 3 LSTM神经网络结构[17]

Fig. 3. LSTM neural network structure.

表 1 灰色关联度分析值

Table 1. Grey relational analysis value.

变量特征 风速 风向 温度 压强 湿度 实发辐照度 Y 0.34 0.28 0.45 0.01 0.62 0.97 表 2 模型预测误差指标

Table 2. Error index of model prediction.

模型 CNN LSTM CNN-LSTM GA-CNN-LSTM MAE 0.34765 0.36681 0.28763 0.21424 MSE 0.65034 0.63447 0.60437 0.58529 RMSE 0.80643 0.77431 0.69321 0.61213 MAPE 0.06013 0.06233 0.05439 0.04476 表 3 模型运行时间

Table 3. Model running time.

模型 CNN LSTM CNN-LSTM GA-CNN-LSTM 训练时间/s 456.434 51.576 611.880 503.740 测试时间/s 1.130 1.220 3.690 2.770 -

[1] Wang K, Qi X, Liu H 2019 Appl. Energy 251 113315

Google Scholar

Google Scholar

[2] Kushwaha V, Pindoriya N M 2019 RenewableEnergy 140 124

Google Scholar

Google Scholar

[3] Shi J, Lee W J, Liu Y, Yang Y, Wang P 2012 IEEE Trans. Ind. Appl. 48 1064

Google Scholar

Google Scholar

[4] Liu Y, Zhao J, Zhang M, et al. 2016 The 12th International Conference on Natural Computation, Fuzzy Systems and Knowledge Discovery, Changsha, August, 2016 p29

[5] Liu L, Zhao Y, Chang D, Xie J, Ma Z, Sun Q, Wennersten R 2018 Appl. Energy 228 70

[6] Gao M, Li J, Hong F, Long D 2019 Energy 187 115

[7] Abdel-Nasser M, Mahmoud K 2019 Neural Comput. Appl. 31 2727

Google Scholar

Google Scholar

[8] 魏小辉 2019 硕士学位论文 (兰州: 兰州大学)

Wei X H 2019 M. S. Thesis (Lanzhou: Lanzhou University) (in Chinese)

[9] SrivastavaN, Hinton G, Krizhevsky A, et al. 2014 J. Mach. Learn Res. 15 1929

[10] https://www.pkbigdata.com/common/cmptIndex.html[2019-12-20]

[11] Ashburner J, Friston K J 1999 Hum. Brain Mapp. 7254

[12] Wei G W 2011 Expert Syst. Appl. 38 4824

Google Scholar

Google Scholar

[13] Wang K, Qi X, Liu H 2019 Energy 189 116225

Google Scholar

Google Scholar

[14] Chua L O 1997 Int. J. Bifurcation Chaos 7 2219

Google Scholar

Google Scholar

[15] SajjadM, Khan S, Hussain T, Muhammad K, Sangaiah A K, Castiglione A, Baik S W 2019 Pattern Recognit. Lett. 126 123

Google Scholar

Google Scholar

[16] Xiao F, Xiao Y, Cao Z, Gong K, Fang Z, Zhou J T 2019 Tenth International Conference on Graphics and Image Processing, Chengdu, China, 2018 p11069

[17] Hüsken M, Stagge P 2003 Neurocomputing 50 223

Google Scholar

Google Scholar

[18] Qing X, Niu Y 2018 Energy 148 461

Google Scholar

Google Scholar

[19] Ordóñez F, Roggen D 2016 Sensors 16 115

Google Scholar

Google Scholar

[20] Tan Z X, Goel A, Nguyen T S, Ong D C 2019 14th IEEE International Conference on Automatic Face & Gesture Recognition, Lille, France, May 14−18, 2019 p1

[21] Gensler A, Henze J, Sick B, et al. 2016 IEEE International Conference on Systems, Man, and Cybernetics, Budapest, Hungary, October 9−12, 2016 p002858

[22] Zhou X, Wan X, Xiao J 2016 Proceedings of the 2016 Conference on Empirical Methods in Natural Laguage Proccessing, Texas, USA, November 1−5, 2016 p247

[23] Goldberg D E, Samtani M P 1986 In Electronic Computation American Society of Civil Engineers, American, February 1986 p471

[24] Willmott C J, Matsuura K 2005 Clim. Res. 30 79

Google Scholar

Google Scholar

[25] Ip W C, Hu B Q, Wong H, Xia J 2009 J. Hydrol. 379 284

Google Scholar

Google Scholar

计量

- 文章访问数: 22763

- PDF下载量: 491

- 被引次数: 0

下载:

下载: